Вступ до команд Hadoop fs

У цій статті ми розглянемо команди обробки файлів HADOOP, які використовуються для управління файлами через консоль.

Вам знадобиться система Linux та остання версія Hadoop. Щоб надрукувати версію Hadoop, щоб знати, ким був побудований реліз, значення контрольної суми, нам просто потрібно виконати команду нижче після входу в платформу Hadoop.

Команда: версія Hadoop

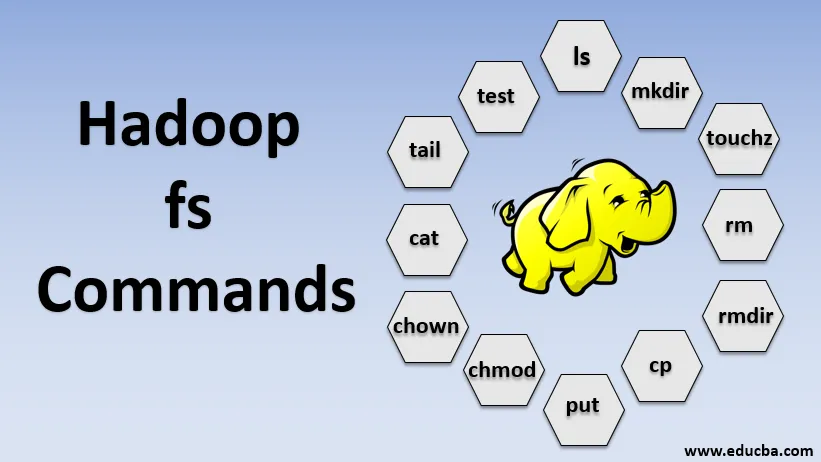

Команди Hadoop fs

Тепер давайте дізнаємося, як використовувати команди HADOOP fs.

Почнемо з основ. Просто введіть ці команди в PUTTY або будь-якій консолі, з якою вам зручно.

1. hadoop fs -ls

Для каталогу він повертає список файлів і каталогів, тоді як для файлу він повертає статистичні дані про файл.

hadoop fs -lsr: це для рекурсивного переліку каталогів та файлів під певні папки.

- Приклад : hadoop fs -ls / або hadoop fs -lsr

- -d: використовується для переліку каталогів як звичайних файлів.

- -h: використовується для форматування розмірів файлів у читаному для людини форматі, ніж просто кількість байтів.

- -R: Це використовується для рекурсивного переліку вмісту каталогів.

2. hadoop fs -mkdir

Ця команда приймає шлях як аргумент і створює каталоги в hdfs.

- Приклад : hadoop fs -mkdir / user / datahub1 / data

3. hadoop fs -touchz

Він створює порожній файл і не використовує місця

- Приклад: hadoop fs -touchz URI

4. hadoop fs -rm

Видаліть файли, вказані як аргумент. Ми повинні вказати параметр -r для видалення всього каталогу. І якщо вказано параметр -skipTrash, воно пропустить кошик і файл буде видалено негайно.

- Приклад : hadoop fs -rm -r /user/test1/abc.text

5. hadoopfs -rmdir

Він видаляє файли та дозволи довідників та підкаталогів. В основному це розширена версія Hadoop fs -rm.

6. hadoop fs -cp

Він копіює файл з одного місця в інше

- Приклад : hadoop fs -cp /user/data/abc.csv / user / datahub

7. hadoop fs -copyFromLocal

Він копіює файл з edgenode в HDFS.

8. hadoop fs -put

Він копіює файл з edgenode в HDFS, він аналогічний попередній команді, але ставить також зчитує вхід зі стандартного вводу stdin і записує в HDFS

- Приклад : hadoop fs -put abc.csv / user / data

hadoop fs -put -p: прапор зберігає доступ, час модифікації, право власності та режим.

hadoop fs -put -f: Ця команда замінює призначення, якщо файл вже існує перед копією.

9. hadoop fs -moveFromLocal

Це схоже на копіювання з локального, за винятком того, що вихідний файл видаляється з локального едгенода після його копіювання на HDFS

- Приклад : fs -moveFromLocal abc.text / user / data / acb.

10. hadoop fs -copyToLocal

Він копіює файл з HDFS в edgenode.

- Приклад : fs -copyToLocal abc.text / localpath

11. hadoop fs -chmod

Ця команда допомагає нам змінити доступ до файлу чи каталогу

- Приклад : hadoop fs -chmod (-R) (шлях)

12. hadoop fs -хаун

Ця команда допомагає нам змінити право власності на файл або каталог

- Приклад : hadoop fs -chown (-R) (ВЛАСНИК) (:( GROUP)) PATH

13. hadoop fs -cat

Він друкує вміст файлу HDFS на терміналі

- Приклад : hadoop fs -cat /user/data/abc.csv

14. hadoop fs -tail

Він виводить останній КБ HDFS-файлу в stdout

- Приклад : hadoop fs -tail / in / xyzfile

15. hadoop fs -тест

Ця команда використовується для тестових операцій з файлами HDFS, вона повертає 0, якщо це правда.

- - e: перевіряє, чи існує файл.

- -z: перевіряє, чи має файл нульову довжину

- -d / -f: перевіряє, чи відповідає шлях відповідно до каталогу / файлу

Тут ми детально обговорюємо приклад

- Приклад : hadoop fs -test - (defz) /user/test/test1.text

16. hadoop fs -du

Відображає розміри файлів і каталогів, що містяться в даному каталозі, або довжину файлу, якщо це файл

17. hadoop fs -df

Він відображає вільний простір

18. hadoop fs -checksum

Повертає інформацію про контрольну суму файлу

19. hadoop fs -getfacl

Він відображає список контролю доступу (ACL) конкретного файлу чи каталогу

20. hadoop fs -счет

Він підраховує кількість каталогів, файлів та байтів під контуром, який відповідає заданому шаблону файлу.

21. hadoop fs -setrep

Змінює коефіцієнт реплікації файлу. А якщо шлях - це каталог, то команда змінює коефіцієнт реплікації всіх файлів у каталозі.

- Приклад : hadoop fs -setrep -R / user / datahub: він використовується для прийняття зворотної можливості і не має ефекту.

hadoop fs - setrep -w / user / datahub : чекає завершення реплікації

22. hadoop fs -getmerge

Він об'єднує файли HDFS у вихідному коді в місцевий файл призначення

- Приклад : hadoop fs -getmerge / user / datahub

23. hadoop fs -appendToFile

Додає одне джерело або кілька джерел з локальної файлової системи до місця призначення.

- Приклад : hadoop fs -appendToFile xyz.log data.csv / in / appendfile

24. hadoop fs -stat

Він друкує статистику про файл чи каталог.

- Приклад : hadoop fs -stat (формат)

Висновок - Команди Hadoop fs

Отже, ми пройшли майже всі команди, необхідні для обробки файлів та перегляду даних усередині файлів. Ви можете змінювати свої файли та передавати дані на платформу Hadoop зараз.

Рекомендовані статті

Це посібник з команд Hadoop fs. Тут ми обговорюємо вступ до команд Hadoop fs разом з її прикладом докладно. Ви також можете переглянути наступні статті, щоб дізнатися більше -

- Встановити Hadoop

- Інструменти Hadoop

- Hadoop Архітектура

- Компоненти Hadoop

- Команди Hadoop fs