Вступ до простої лінійної регресії

Зі словника : повернення до колишнього або менш розвиненого стану.

У статистиці: міра співвідношення між середнім значенням однієї змінної та відповідними значеннями інших змінних.

Регресія, в якій зв'язок між вхідною змінною (незалежна змінна) і цільовою змінною (залежною змінною) вважається лінійною, називається лінійною регресією. Проста лінійна регресія - це тип лінійної регресії, де ми маємо лише одну незалежну змінну для прогнозування залежної змінної. Проста лінійна регресія - один з алгоритмів машинного навчання. Проста лінійна регресія належить до родини контрольованого навчання. Регресія використовується для прогнозування постійних значень.

Модель простої лінійної регресії

Давайте зробимо це простим. Як все почалося?

Все почалося в 1800 році з Френсісом Галтоном. Він вивчав відносини у зрості між батьками та їхніми синами. Він спостерігав закономірність: Зріст або сина був би таким же високим, як і зріст батька, або зріст сина, як правило, буде ближчим до загальної середньої висоти всіх людей. Це явище є не що інше, як регресія.

Наприклад, Шак О'Ніл - дуже відомий гравець у НБА та заввишки 2, 16 метра. Його сини Шакір та Шаріф О'неал мають висоту 1, 96 метра та 2, 06 метра відповідно. Середня висота населення 1, 76 метра. Регрес висоти сина (дрейф у бік) середньої висоти.

Як ми робимо регресію?

Обчислення регресії лише з двома точками даних:

Все, що ми хочемо зробити, щоб знайти найкращий регрес - це провести лінію, максимально наближену до кожної точки. У випадку двох точок даних легко провести лінію, просто приєднайтеся до них.

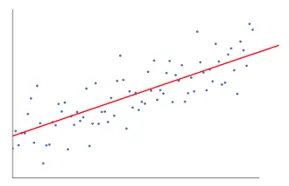

Тепер, якщо зараз у нас є ряд точок даних, як намалювати лінію, максимально наближену до кожної точки даних.

У цьому випадку наша мета - мінімізувати вертикальну відстань між лінією та всіма точками даних. Таким чином ми прогнозуємо найкращу лінію для нашої лінійної регресійної моделі.

Що таке проста лінійна регресія?

Нижче наведено детальне пояснення простої лінійної регресії:

- Він малює багато і багато можливих ліній ліній, а потім робить будь-який з цих аналізів.

- Сума помилок у квадраті.

- Сума абсолютних помилок.

- метод найменшого квадрату… тощо

- Для нашого аналізу ми будемо використовувати метод найменшого квадрату.

- Ми зробимо різницю всіх точок і обчислимо квадрат суми всіх точок. Яка б лінія не дала мінімальну суму, буде найкращою лінією.

Наприклад: таким чином ми могли взяти кількох чоловіків та їхнього сина на зріст і зробити такі речі, як сказати чоловікові, яким високим може бути його син. до того, як він навіть народився.

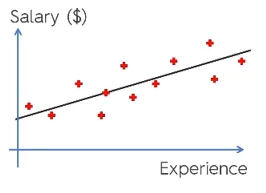

Google Image

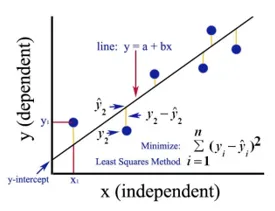

Наведений малюнок показує просту лінійну регресію. Лінія являє собою лінію регресії. Дано: y = a + b * x

Де y - залежна змінна (DV): Наприклад, як змінюється зарплата людини залежно від кількості років досвіду працівника. Тож тут зарплата працівника чи людини буде вашою залежною змінною.

Залежна змінна - наша цільова змінна, та, яку ми хочемо передбачити за допомогою лінійної регресії.

x наша незалежна змінна (IV): залежна змінна є причиною зміни незалежної змінної. У наведеному вище прикладі кількість років досвіду є нашою залежною змінною, оскільки кількість років досвіду викликає зміну зарплати працівника.

- b - коефіцієнт змінної для нашої незалежної змінної x. Цей коефіцієнт відіграє вирішальну роль. Це говорить про те, як зміна одиниці в x (IV) вплине на y (DV). Він також називається коефіцієнтом пропорційним. Що стосується математики, то на вас залежить нахил лінії, або ви можете сказати круту лінію.

- У нашому прикладі, якщо нахил (b) менший, це означає, що кількість років призведе до меншого збільшення зарплати, з іншого боку, якщо нахил (b) буде більшим, це призведе до високого підвищення зарплати зі збільшенням кількості Роки досвіду.

- a - постійне значення. Він також називається перехопленням, тобто там, де лінія перетинає вісь y або вісь DV. Іншим способом можна сказати, коли працівник має нульовий досвід досвіду (x), то зарплата (y) для цього працівника буде постійною (a).

Як працює найменша площа?

Нижче наведено пункти для найменш квадратних робіт:

- Він проводить довільну лінію відповідно до тенденцій даних.

- Він займає точки даних і малює вертикальні лінії. Він розглядає вертикальну відстань як параметр.

- Ці вертикальні лінії вирізають лінію регресії та дають відповідну точку для точок даних.

- Потім він знайде вертикальну різницю між кожною точкою даних та її відповідною точкою даних на лінії регресії.

- Він обчислить помилку, яка є квадратом різниці.

- Потім він обчислює суму помилок.

- Потім знову проведе малюнок і повторить описану вище процедуру ще раз.

- Він малює ряд рядків таким чином, і лінія, яка дає найменшу суму помилок, вибирається найкращою лінією.

- Ця найкраща лінія - наша проста лінійна регресія.

Застосування простої лінійної регресії

Регресійний аналіз виконується для прогнозування безперервної змінної. Регресійний аналіз має широке застосування. Деякі приклади:

- Прогнозована аналітика

- Ефективність маркетингу,

- ціноутворення будь-якого списку

- прогнозування просування товару.

Тут ми розглянемо одне застосування лінійної регресії для прогнозної аналітики. Ми будемо робити моделювання за допомогою python.

Кроки, які ми будемо слідувати, щоб побудувати нашу модель, такі:

- Ми імпортуємо бібліотеки та набори даних.

- Ми попередньо обробимо дані.

- Ми поділимо дані на тестовий набір і навчальний набір.

- Ми створимо модель, яка намагатиметься передбачити цільову змінну на основі нашого навчального набору

- Ми передбачимо цільову змінну для тестового набору.

- Проаналізуємо результати, передбачені моделлю

Для нашого аналізу ми будемо використовувати набір даних про зарплату з даними 30 працівників.

# Імпорт бібліотек

import numpy as np

import matplotlib.pyplot as plt

import pandas as pd

# Імпорт набору даних (Зразок даних показаний у таблиці)

dataset = pd.read_csv('Salary_Data.csv')

| Роки досвіду | Зарплата |

| 1.5 | 37731 |

| 1.1 | 39343 |

| 2.2 | 39891 |

| 2 | 43525 |

| 1.3 | 46205 |

| 3.2 | 54445 |

| 4 | 55749 |

# Попередньо обробляючи набір даних, тут ми розділимо набір даних на залежну змінну та незалежну змінну. x як незалежна та y як залежна або цільова змінна

X = dataset.iloc(:, :-1).values

y = dataset.iloc(:, 1).values

# Розбиття набору даних на навчальний набір і тестовий набір:

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size = 1/3, random_state = 0)

Тут розмір тесту 1/3 показує, що з загальних даних 2/3 частина призначена для навчання моделі, а решта 1/3 використовується для тестування моделі.

# Примістимо нашу просту модель лінійної регресії до навчального набору

from sklearn.linear_model import LinearRegression

regressor = LinearRegression()

regressor.fit(X_train, y_train)

Модель лінійної регресії зараз навчається. Ця модель буде використовуватися для прогнозування залежної змінної.

# Прогнозування результатів тестового набору

y_pred = regressor.predict(X_test)

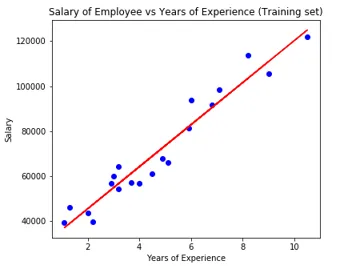

# Візуалізація результатів тестового набору

plt.scatter(X_test, y_test, color = 'blue')

plt.plot(X_train, regressor.predict(X_train), color = 'red')

plt.title('Salary of Employee vs Experience (Test set)')

plt.xlabel('Years of Experience')

plt.ylabel('Salary')

plt.show()

# Параметр моделі

print(regressor.intercept_)

print(regressor.coef_)

26816.19224403119

(9345.94244312)

Отже, значення перехоплювача (а) становить 26816. Це говорить про те, що будь-який свіжий (нульовий досвід) отримав би суму 26816 як зарплату.

Коефіцієнт для нашої моделі вийшов 9345, 94. Це дозволяє при збереженні всіх інших параметрів постійними, зміна однієї одиниці незалежної змінної (років досвіду) призведе до зміни 9345 одиниць зарплати.

Показники оцінки регресії

Для регресійного аналізу в основному доступні 3 важливих методики оцінювання:

- Середня абсолютна помилка (MAE): вона показує середнє значення абсолютних помилок, що є різницею між передбачуваною та фактичною.

- Середня помилка у квадраті (MSE): відображає середнє значення помилок у квадраті.

- Середньоквадратична помилка (RMSE): вона показує квадратний корінь середнього значення помилок у квадраті.

Ми можемо порівняти наведені вище методи:

- МАЕ: Він показує середню помилку і найпростіший з усіх трьох методів.

- MSE: Цей популярний, ніж MAE, оскільки він збільшує більше помилок, що в результаті показує більше інформації.

- RMSE: Це краще, ніж MSE, оскільки ми можемо інтерпретувати помилку через y.

Ці 3 - це не що інше, як функції втрат.

# Оцінка моделі

from sklearn import metrics

print('MAE:', metrics.mean_absolute_error(y_test, y_pred))

print('MSE:', metrics.mean_squared_error(y_test, y_pred))

print('RMSE:', np.sqrt(metrics.mean_squared_error(y_test, y_pred)))

MAE: 3426.4269374307123

MSE: 21026037.329511296

RMSE: 4585.4157204675885

Висновок

Лінійний регресійний аналіз - це потужний інструмент алгоритмів машинного навчання, який використовується для прогнозування постійних змінних, таких як зарплата, продажі, продуктивність тощо. Лінійна регресія розглядає лінійний зв’язок між незалежними та залежними змінними. Проста лінійна регресія має лише одну незалежну змінну, на основі якої модель передбачає цільову змінну. Ми обговорили модель та застосування лінійної регресії на прикладі прогнозного аналізу для прогнозу зарплати працівників.

Рекомендовані статті

Це посібник з простої лінійної регресії. Тут ми обговорюємо модель та застосування лінійної регресії, використовуючи приклад прогнозного аналізу для прогнозування зарплат працівників. Ви також можете ознайомитись з іншими пов'язаними з нами статтями, щоб дізнатися більше -

- Лінійний регресійний аналіз

- Лінійна регресія в R

- Лінійне регресійне моделювання

- Інструменти тестування регресії

- Matplotlib In Python | 14 кращих сюжетів у Матплотлібі

- Словник в Python | Методи та приклади

- Приклади квадратного кореня в PHP

- Лінійна регресія проти логістичної регресії | Основні відмінності