Вступ до Hadoop Framework

Перш ніж глибоко зануритися в технічні рамки Hadoop, ми почнемо з простого прикладу.

Є господарство, яке збирає помідори і зберігає їх в єдиному сховищі, тепер із зростанням попиту на овочі, господарство почало збирати картоплю, моркву - зі зростанням попиту бракувало фермерів, тому вони найняли більше фермерів. Через деякий час вони зрозуміли, що в складі зберігається дефіцит - тому вони розподілили овочі по різних місцях зберігання. Що стосується отримання даних, всі вони працюють паралельно з власним простором зберігання.

То як ця історія пов'язана з великими даними?

Раніше ми мали обмежені дані, з обмеженим процесором і одним блоком зберігання. Але потім генерація даних зросла, що призвело до великого обсягу та різних різновидів - структурованих, напівструктурованих та неструктурованих. Тому рішенням було використовувати розподілене сховище для кожного процесора, це дало можливість легкого доступу до зберігання та доступу до даних.

Тож тепер ми можемо замінити овочі на різні види даних та місця зберігання, як розподілені місця для зберігання даних, так і різних працівників, що є кожним процесором.

Тож великі дані - це виклик, і Hadoop грає роль рішення.

HADOOP

1. Рішення для ВЕЛИЧИХ ДАНИХ: оскільки він має справу зі складними великими обсягами, швидкістю та різноманітністю даних.

2. Набір проекту з відкритим кодом.

3. Зберігає величезний об'єм даних надійно і дозволяє здійснювати величезні розподілені обчислення.

4. Основними атрибутами Hadoop є надмірність та надійність (абсолютно відсутні втрати даних).

5. Переважно фокусується на пакетній обробці.

6. Діє на товарне обладнання - вам не потрібно купувати якесь спеціальне дороге обладнання.

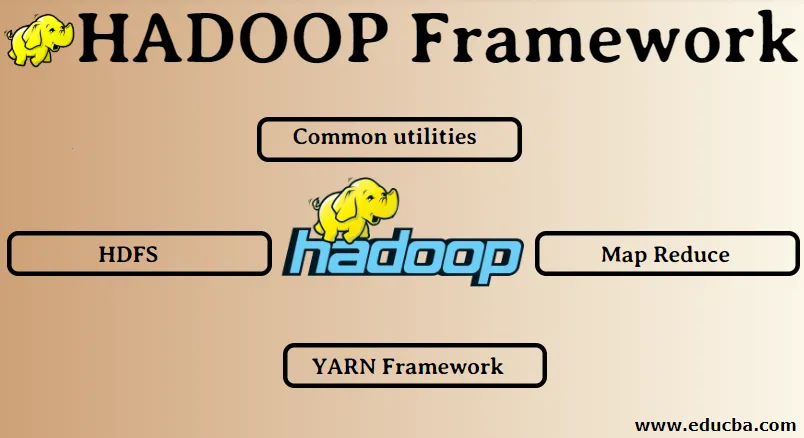

Рамка Hadoop:

1. Загальні комунальні послуги

2. HDFS

3. Зменшення карти

4. Рамка ПРАВ

1. Загальні комунальні послуги:

Також називається Hadoop звичайний. Це не що інше, як бібліотеки, файли, сценарії та утиліти JAVA, які фактично потрібні іншим компонентам Hadoop для виконання.

2. HDFS: Розподілена файлова система Hadoop

Чому Hadoop вирішив включити розподілену файлову систему?

Розберемо це на прикладі: нам потрібно прочитати 1 ТБ даних, і у нас є одна машина з 4 каналами вводу / виводу, кожен канал має 100 МБ / с, для зчитування всіх даних знадобилося 45 хвилин. Тепер та сама кількість даних зчитується 10 машинами на кожному з 4 каналами вводу / виводу, кожен канал має 100 МБ / с. Здогадайтесь, скільки часу знадобилося для читання даних? 4, 3 хвилини. HDFS вирішує проблему зберігання великих даних. Двома основними компонентами HDFS є NAME NODE та DATA NODE. Вузол імені є головним, у нас може бути також і вторинний вузол імені, якщо первинний вузол імені перестане працювати, вторинний вузол імені буде виконувати функції резервного копіювання. Вузол імен в основному підтримує та керує вузлами даних, зберігаючи метадані. Вузол даних - це підлеглий, який в основному є дешевим товарним обладнанням. У нас може бути кілька вузлів даних. Вузол даних зберігає фактичні дані. Цей вузол даних підтримує коефіцієнт реплікації, припустимо, якщо один вузол даних опускається вниз, то до них можна отримати доступ іншим реплікаційним вузлом даних, отже, доступність даних покращується і втрата даних запобігається.

3. Зменшення карти:

Він вирішує проблему обробки великих даних. Давайте розберемося, як поняття карти зменшується, вирішуючи цю реальну проблему. Компанія ABC хоче підрахувати загальний обсяг продажів. Тепер тут концепція хеш-таблиці не працюватиме, оскільки дані знаходяться в терабайтах, тому ми будемо використовувати концепцію Map-Reduce.

Існує дві фази: а) ПДЧ. б) Зменшення

а) Карта : Спочатку ми розділимо дані на менші шматки, які називаються картографами на основі пари ключ / значення. Тож тут ключовою буде назва міста, а значення - загальний обсяг продажів. Кожен картограф отримуватиме дані кожного місяця, що дає назву міста та відповідні продажі.

b) Скорочення: буде отримано ці стоси даних, і кожен редуктор буде відповідати за міста Північ / Захід / Схід / Південь. Таким чином, робота редуктора буде збирати ці невеликі шматки та перетворювати їх на більшу кількість (додаючи їх) для певного міста.

4.YARN Framework: Ще один переговорник ресурсів.

Початкова версія Hadoop мала всього два компоненти: зменшення карт та HDFS. Пізніше було зрозуміло, що зменшення карт не може вирішити безліч великих проблем з даними. Ідея полягала в тому, щоб зняти обов'язки з управління ресурсами та планування завдань від старої системи зменшення карт та передати її новому компоненту. Отже, ось так, як ПАРТА увійшла до картини. Саме управління серед ресурсів кластера відповідає середньому шару між HDFS та Map Reduce.

Виконувати дві ключові ролі: а) Розклад робочих місць. б) управління ресурсами

a) Планування робочих місць: Коли велика кількість даних видається на обробку, її потрібно розподілити і розділити на різні завдання / завдання. Тепер СР вирішує, якій роботі потрібно надати основний пріоритет, часовий інтервал між двома робочими місцями, залежність між робочими місцями, перевіряє, чи немає перекриття між виконаними роботами.

b) Управління ресурсами: для обробки даних та для зберігання даних нам потрібні ресурси, правда? Таким чином, менеджер ресурсів забезпечує, управляє та підтримує ресурси для зберігання та обробки даних.

Тож тепер нам зрозуміло поняття Hadoop та те, як воно вирішує проблеми, створені ВЕЛИКИМИ ДАНИМИ !!!

Рекомендовані статті

Це було керівництвом Hadoop Framework. Тут ми також обговорили топ-4 рамок Hadoop. Ви також можете ознайомитися з іншими запропонованими нами статтями, щоб дізнатися більше -

- База даних Hadoop

- Екосистема Hadoop

- Використання Hadoop

- Робота адміністратора Hadoop

- Hadoop Administrator | Навички та шлях до кар’єри