Вступ до алгоритмів класифікації

У цій статті про класифікаційні алгоритми розміщено огляд різних методів класифікації, які зазвичай використовуються в методах обміну даними з різними принципами. Класифікація - це техніка, яка класифікує дані за окремою кількістю класів і по черзі мітка присвоюється кожному класу. Основна мета класифікації - визначити клас для запуску нових даних шляхом аналізу навчального набору, бачачи належні межі. Загалом прогнозування цільового класу та вищевказаний процес називається класифікацією.

Наприклад, керівництво лікарні записує ім’я, адресу, вік, попередню історію здоров'я пацієнта для встановлення діагнозу, це допомагає класифікувати пацієнтів. Їх можна охарактеризувати на дві фази: етап навчання та етап оцінювання. Моделі фаз навчання підхідна база не містить даних про навчання, тоді як етап оцінювання передбачає вихід для даних даних. Ми могли знайти їх застосування в електронному спамі, прогнозуванні банківських позик, розпізнаванні мови, аналізі почуттів. Методика включає математичну функцію f з входом X і виходом Y.

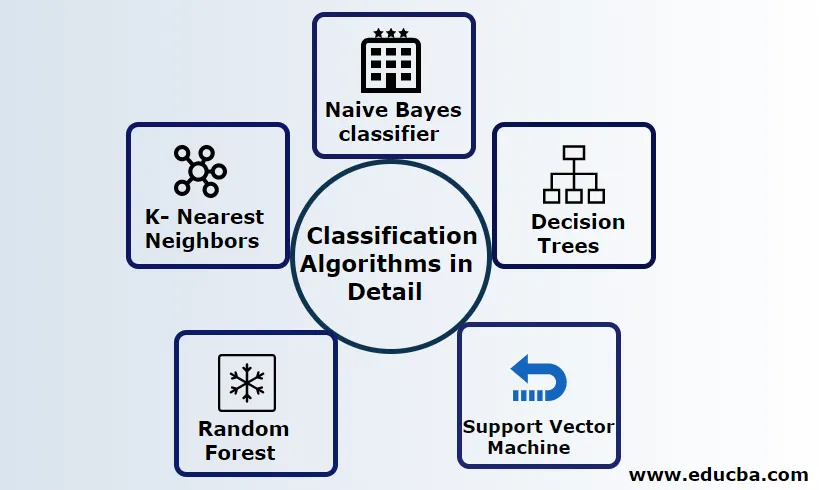

Поясніть алгоритми класифікації детально

Класифікація може здійснюватися як за структурованими, так і за неструктурованими даними. Класифікацію можна класифікувати

- Наївний класифікатор Байєса

- Дерева рішень

- Підтримка векторної машини

- Випадковий ліс

- K- Найближчі сусіди

1) Наївний класифікатор Байєса

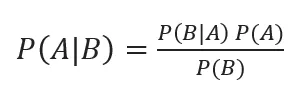

Це алгоритм, заснований на теоремі Байєса, одна із статистичних класифікацій і вимагає невеликої кількості навчальних даних для оцінки параметрів, також відомих як імовірнісні класифікатори. Він вважається найшвидшим класифікатором, високо масштабованим та обробляє як дискретні, так і безперервні дані. Цей алгоритм використовується для прогнозування в режимі реального часу. Існують різні типи наївного класифікатора, мультиноміальний наївний байєс, наєвський Бернуллі, наївний гаусс.

Байєсова класифікація із задніми ймовірностями задана

Де A, B події, P (A | B) - задні ймовірності.

Якщо два значення не залежать одне від одного, то

P (A, B) = P (A) P (B)

Naive Bayes можна побудувати за допомогою бібліотеки python. Прогнози Naive не залежать, хоча вони використовуються в системах рекомендацій. Вони використовуються у багатьох додатках у режимі реального часу та добре свідомо використовуються при класифікації документів.

Переваги:

Переваги полягають у тому, що вони вимагають дуже меншої обчислювальної потужності, яка передбачається в задачах передбачення декількох класів, точно працюють над великими наборами даних.

Недолік:

Основним недоліком цього класифікатора є те, що вони призначать нульову ймовірність. І вони мають функції, незалежні одна від одної.

2) Дерево рішень

Це модель підходу зверху вниз зі структурою блок-схеми обробляє дані з високими розмірами. Результати прогнозуються на основі заданої вхідної змінної. Дерево рішень складається з таких елементів: Корінь, багато вузлів, гілок, листя. Кореневий вузол робить розділ на основі значення атрибуту класу, внутрішній вузол приймає атрибут для подальшої класифікації, гілки приймають правило про розподіл вузлів на вузли листя, нарешті, вузли листів дають нам остаточний результат. Складність часу дерева рішень залежить від кількості записів, атрибутів навчальних даних. Якщо дерево рішень занадто довге, важко отримати бажані результати.

Перевага: Вони застосовуються для прогностичної аналітики для вирішення проблем і застосовуються в щоденній діяльності для вибору цілі на основі аналізу рішень. Автоматично будує модель на основі вихідних даних. Найкраще в обробці відсутніх значень.

Недолік: Розмір дерева не може бути контрольованим, поки він не має деяких критеріїв зупинки. Завдяки їх ієрархічній структурі дерево нестабільне.

3) Підтримка векторної машини

Цей алгоритм відіграє найважливішу роль у проблемах класифікації та найчастіше в алгоритмах керованого машинного навчання. Це важливий інструмент, який використовує дослідник і вчений. Цей SVM дуже простий, і його процес полягає у знаходженні гіперплощини в N-мірних точках простору даних. Гіперплани - це межі рішення, які класифікують точки даних. Весь цей вектор падає ближче до гіперплану, максимізуючи запас класифікатора. Якщо маржа максимальна, найнижчою є помилка узагальнення. Їх реалізація може здійснюватися з ядром за допомогою python з деякими навчальними наборами даних. Основна мета SVM - навчити об'єкт до певної класифікації. SVM не обмежується лінійним класифікатором. SVM є кращим, ніж будь-яка модель класифікації, завдяки їх функції ядра, що покращує обчислювальну ефективність.

Перевага: вони вкрай переважні, оскільки їх менша обчислювальна потужність та ефективна точність. Ефективний у просторі з високими розмірами, хороша ефективність пам'яті.

Недолік: обмеження швидкості, ядра та розміру

4) Випадковий ліс

Це потужний алгоритм машинного навчання, заснований на підході до вивчення ансамблю. Основний будівельний блок випадкового лісу - це дерево рішень, яке використовується для побудови прогнозних моделей. Демонстрація роботи включає створення лісу дерев з випадковими рішеннями, а процес обрізки виконується за допомогою встановлення зупиночного розщеплення для отримання кращого результату. Випадковий ліс реалізується за допомогою методики, званої пакетування для прийняття рішень. Таке пакетування запобігає переповненню даних, зменшуючи ухил аналогічно, що цей випадковий спосіб може досягти кращої точності. Остаточний прогноз береться в середньому з багатьох дерев рішень, тобто частих прогнозів. Випадковий ліс включає багато випадків використання, таких як прогнози фондового ринку, виявлення шахрайства, прогнози новин.

Переваги:

- Для обробки наборів даних не потрібна велика обробка та дуже проста модель для побудови. Забезпечує більшу точність допомагає у вирішенні завдань прогнозування.

- Добре працює в обробці пропущених значень і автоматично виявляє сторонність.

Недолік:

- Потрібна висока обчислювальна вартість та висока пам'ять.

- Вимагає набагато більше періоду часу.

5) K- Найближчі сусіди

Тут ми обговоримо алгоритм K-NN з контрольованим навчанням для CART. Вони використовують K додатне мале ціле число; об’єкт присвоюється класу на основі сусідів, або ми скажемо присвоєння групі, спостерігаючи, в якій групі лежить сусід. Це вибирається мірою відстані Евклідової відстані та грубою силою. Значення K можна знайти за допомогою процесу настройки. KNN не вважає за краще вивчати будь-яку модель для підготовки нового набору даних та використання нормалізації для масштабування даних.

Перевага: дає ефективні результати, якщо дані про навчання є величезними.

Недолік: Найбільша проблема полягає в тому, що якщо мала змінна, вона працює добре. По-друге, вибір фактора K при класифікації.

Висновок

На закінчення ми переглянули можливості різних алгоритмів класифікації, як і раніше, є потужним інструментом у конструюванні функцій, класифікація зображень, яка відіграє чудовий ресурс для машинного навчання. Алгоритми класифікації - це потужні алгоритми, що вирішують важкі проблеми.

Рекомендовані статті

Це посібник з класифікаційних алгоритмів машинного навчання. Тут ми обговорюємо, що Класифікація може бути виконана як за структурованими, так і за неструктурованими даними. Ви також можете ознайомитися з іншими запропонованими нами статтями -

- Алгоритми маршрутизації

- Алгоритм кластеризації

- Процес обміну даними

- Алгоритми машинного навчання

- Найчастіше використовувані методи ансамблевого навчання

- Алгоритм C ++ | Приклади алгоритму С ++