Вступ до методів машинного навчання

У наступній статті "Методи машинного навчання" подано конфігурацію найбільш часто використовуваних методів у машинному навчанні. Машинне навчання - це техніка, завдяки якій комп'ютер може самостійно «вчитися» речам. Алгоритми адаптивно покращують свою ефективність, оскільки збільшуються дані, доступні для навчання. Тобто Чим більше даних, тим точнішою буде наша модель.

Як навчаються машини?

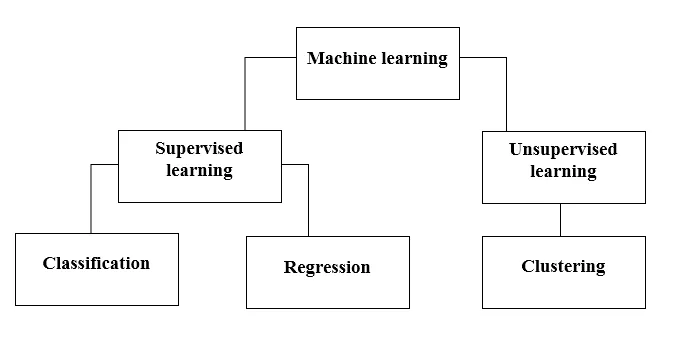

Існують різні методи для цього. Який метод повністю використовувати, залежить від постановки проблеми. Залежно від набору даних та нашої проблеми є два різні способи заглибитись. Один - це контрольоване навчання, а інший - непідвладне навчання. Наступний графік пояснює подальшу класифікацію методів машинного навчання. Ми обговоримо їх по черзі.

Погляньте на наступний графік!

Давайте розберемося, що означає наглядове навчання.

Контрольоване навчання

Як випливає з назви, уявіть собі вчителя чи керівника, який допомагає вам вчитися. Те саме стосується машин. Ми тренуємо машину або навчаємо її за допомогою даних, що позначені міткою.

Одні з найкрутіших контрольованих програм навчання:

- Аналіз почуттів (Twitter, Facebook, Netflix, YouTube тощо)

- Обробка природних мов

- Класифікація зображень

- Прогностичний аналіз

- Розпізнавання образів

- Виявлення спаму

- Обробка мови / послідовності

Тепер контрольоване навчання далі поділяється на класифікацію та регресію. Давайте зрозуміємо це.

Класифікація

Класифікація - це процес пошуку моделі, яка допомагає розділити дані на різні категоріальні класи. У цьому процесі дані класифікуються під різними мітками відповідно до деяких параметрів, наведених у вводі, і тоді мітки прогнозуються для даних. Категоричне означає, що вихідною змінною є категорія, тобто червоний або чорний, спам або не спам, діабетичний або недіабетичний тощо.

Класифікаційні моделі включають в себе підтримку векторної машини (SVM), K-найближчого сусіда (KNN), Naive Bayes тощо.

a) Підтримка векторного машинного класифікатора (SVM)

SVM - це контрольований метод навчання, який розглядає дані і сортує їх в одну з двох категорій. Я використовую гіперплан для категоризації даних. Лінійний дискримінаційний класифікатор намагається провести пряму, що розділяє два набори даних і тим самим створити модель для класифікації. Він просто намагається знайти лінію чи криву (у двох вимірах) або колектор (у декількох вимірах), що розділяє класи один від одного.

Примітка. Для багатокласової класифікації SVM використовує "один проти інших", це означає обчислення різних SVM для кожного класу.

б) K-найближчий класифікатор сусідів (KNN)

- Якщо ви уважно читаєте, сама назва підказує, що робить алгоритм. KNN вважає, що точки даних, які є ближчими, значно схожіші за характеристиками, а отже, швидше за все, належать до того ж класу, що і сусід. Для будь-якої нової точки даних обчислюється відстань до всіх інших точок даних і визначається клас на основі K найближчих сусідів. Так, це може звучати кульгаво, але для деяких класифікацій це працює як що завгодно.

- Точка даних класифікується за максимальною кількістю голосів своїх сусідів, тоді точка даних присвоюється найближчому класу серед своїх k-сусідів.

- У KNN не потрібно вивчати модель, і вся робота відбувається в той момент, коли запитується прогноз. Ось чому KNN часто називають алгоритмом ледачого навчання.

c) класифікатор Naive Naes

- Naive Bayes - це алгоритм машинного навчання, який дуже рекомендується для проблем класифікації тексту. Він заснований на теоремі ймовірності Байєса. Ці класифікатори називаються наївними, оскільки вони припускають, що змінні функції не залежать одна від одної. Це означає, що, наприклад, у нас є повне речення для введення, тоді Наї Байес припускає, що кожне слово в реченні не залежить від інших. А потім класифікуйте їх відповідно. Я знаю, це виглядає досить наївно, але це чудовий вибір для проблем класифікації тексту, і це популярний вибір для класифікації електронної пошти зі спамом.

- Він надає різні типи алгоритмів наївних баєсів, такі як БернулліNB, ГауссовийNB, мультиноміальний NB.

- Він вважає, що всі функції не пов'язані між собою, тому він не може дізнатися взаємозв'язок між функціями. Наприклад, скажімо, Варун любить їсти гамбургери, він також любить їсти картоплю фрі з коксом. Але він не любить їсти бургер і поєднання картоплі фрі з коксом разом. Тут Наї Байес не може навчитися співвідношенню двох особливостей, а лише дізнається лише індивідуальну важливість функції.

Тепер перейдемо до іншої сторони нашого контрольованого методу навчання, який є регресією.

Регресія

Регресія - це процес пошуку моделі, яка допомагає диференціювати дані за допомогою постійних значень. При цьому впорядковується характер прогнозованих даних. Деякі з найбільш широко використовуваних регресійних моделей включають лінійну регресію, випадковий ліс (дерева рішень), нейронні мережі.

Лінійна регресія

- Один з найпростіших підходів у контрольованому навчанні, який корисний при прогнозуванні кількісної відповіді.

- Лінійна регресія включає пошук найкращої прямої лінії через точки. Найкраще підходить лінія називається регресійною лінією. Лінія найкращого пристосування точно не проходить через усі точки даних, але натомість намагається найкраще наблизитися до них.

- Це широко використовуваний алгоритм для безперервних даних. Однак він зосереджується лише на середньому значенні залежної змінної і обмежується лінійним співвідношенням.

- Лінійна регресія може використовуватися для часових рядів, прогнозування тенденцій. Він може передбачити майбутні продажі, грунтуючись на попередніх даних.

Навчання без нагляду

- Навчання без нагляду базується на підході, який можна вважати відсутністю викладача, а отже, і абсолютними заходами помилок. Це корисно, коли потрібно вивчити кластеризацію чи групування елементів. Елементи можна групувати (кластеризувати) за їх подібністю.

- При навчанні без нагляду дані маркуються, не класифікуються, а алгоритми системи діють на дані без попередньої підготовки. Алгоритми навчання без нагляду можуть виконувати більш складні завдання, ніж алгоритми з контрольованим навчанням.

- Непідконтрольне навчання включає кластеризацію, яку можна здійснити за допомогою засобів K кластеризації, ієрархічної, гауссової суміші, прихованої моделі Маркова.

Непідконтрольні програми навчання:

- Виявлення подібності

- Автоматичне маркування

- Сегментація об'єктів (наприклад, особи, тварини, фільми)

Кластеризація

- Кластеризація - це непідвладний метод навчання, який використовується для аналізу даних у багатьох сферах. Алгоритм кластеризації стає корисним, коли ми хочемо отримати детальну інформацію про наші дані.

- Справжнім прикладом кластеризації можуть бути жанрові кластери Netflix, які розділені для різних цільових клієнтів, включаючи інтереси, демографічні показники, спосіб життя тощо. замовники.

а) K означає Кластеризація

- K означає алгоритм кластеризації намагається розділити задані невідомі дані на кластери. Він випадковим чином вибирає "k" кластеридів центроїдів, обчислює відстань між точками даних та центрами кластерів, а потім, нарешті, призначає точку даних центроїду кластера, відстань якого мінімальна від усіх центроїдів кластера.

- У k-засобах групи визначаються найближчим центроїдом для кожної групи. Цей центроїд діє як «Мозок» алгоритму, вони набувають найближчих до них точок даних, а потім додають їх у кластери.

б) Ієрархічна кластеризація

Ієрархічна кластеризація майже схожа на звичайну кластеризацію, якщо ви не хочете створити ієрархію кластерів. Це може стати в нагоді, коли ви хочете визначити кількість кластерів. Наприклад, припустимо, ви створюєте групи різних предметів в інтернет-продуктовому магазині. На головній сторінці ви хочете кілька широких предметів, і як тільки ви натиснете один із елементів, відкриються конкретні категорії, тобто більш конкретні кластери.

Зменшення розмірності

Зменшення розмірності може розглядатися як стиснення файлу. Це означає, виймаючи інформацію, яка не є актуальною. Це знижує складність даних і намагається зберегти змістовні дані. Наприклад, при стисненні зображення ми зменшуємо розмірність простору, в якому зображення залишається таким, як воно є, не руйнуючи занадто багато змістовного змісту зображення.

PCA для візуалізації даних

Аналіз основних компонентів (PCA) - це метод зменшення розмірів, який може бути корисним для візуалізації ваших даних. PCA використовується для стиснення даних більш високих розмірів до даних з низькими розмірами, тобто ми можемо використовувати PCA для зменшення чотиривимірних даних у три або 2 виміри, щоб ми могли візуалізувати та отримати краще розуміння даних.

Рекомендовані статті

Це посібник з методів машинного навчання. Тут ми обговорили вступ: Як машини навчаються? класифікації машинного навчання та блок-схеми, а також детальне пояснення. Ви також можете ознайомитися з іншими запропонованими нами статтями, щоб дізнатися більше -

- Архітектура машинного навчання

- Рамки машинного навчання

- Інструменти машинного навчання

- Методи машинного навчання

- Гіперпараметр машинного навчання

- Ієрархічний алгоритм кластеризації

- Ієрархічна кластеризація | Агломераційна та роздільна кластеризація