Вступ до перенесення та підсилення

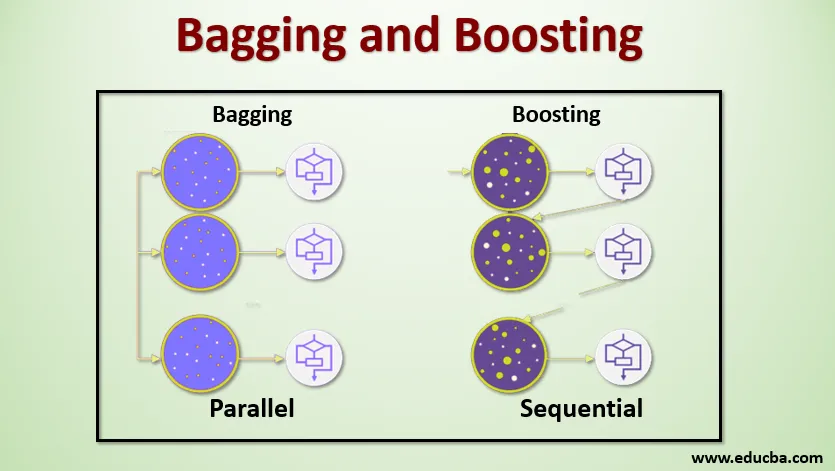

Баггінг та підсилення - це два популярні методи ансамблю. Отже, перш ніж зрозуміти Bagging і Boosting, давайте мати уявлення про те, що таке ансамбль Learning. Це методика використання декількох алгоритмів навчання для підготовки моделей з одним і тим же набором даних для отримання прогнозу в машинному навчанні. Отримавши прогноз від кожної моделі, ми використовуватимемо методи середнього моделювання, такі як середнє зважене значення, дисперсія або максимальне голосування, щоб отримати остаточний прогноз. Цей метод спрямований на отримання кращих прогнозів, ніж окрема модель. Це призводить до кращої точності, уникаючи переобладнання та зменшує упередженість та співвіднесення. Два популярні методи ансамблю:

- Мішок (агрегування завантажувача)

- Підвищення

Мішок:

Баггінг, також відомий як Bootstrap Aggregating, використовується для підвищення точності і робить модель більш узагальненою, зменшуючи дисперсію, тобто уникаючи переобладнання. У цьому ми беремо кілька підмножин навчального набору даних. Для кожного підмножини ми беремо модель з тими ж алгоритмами навчання, як дерево рішень, логістична регресія тощо, щоб передбачити вихід для одного і того ж набору тестових даних. Після того, як у нас є прогнозування для кожної моделі, ми використовуємо техніку усереднення моделі, щоб отримати остаточний результат прогнозування. Однією з відомих методик, що застосовуються в мішкуванні, є випадковий ліс . У випадковому лісі ми використовуємо кілька дерев рішень.

Підвищення :

Підвищення в першу чергу використовується для зменшення упередженості та розбіжності в контрольованій техніці навчання. Він відноситься до сімейства алгоритму, який перетворює слабких учнів (базових учнів) у сильних учнів. Слабкий учень - це класифікатори, які лише в незначній мірі відповідають дійсній класифікації, тоді як сильні учні - це класифікатори, які добре співвідносяться з фактичною класифікацією. Мало відомі методи прискорення - AdaBoost, GRADIENT BOOSTING, XgBOOST (Extreme Gradient Boosting). Отож, тепер ми знаємо, що таке розфасування та прискорення та які їх ролі в машинному навчанні.

Робота мішків та підсилення

Тепер давайте розберемося, як працює мішок та прискорення:

Баггінг

Щоб зрозуміти роботу Baging, припустимо, що у нас є N кількість моделей та набір даних D. Де m - кількість даних, а n - кількість особливостей у кожному даних. І ми повинні робити бінарну класифікацію. Спочатку ми розділимо набір даних. Наразі ми розділимо цей набір даних лише на навчальний і тестовий набір. Назвемо навчальний набір даних як де загальна кількість навчальних прикладів.

Візьміть зразок записів із навчального набору і використовуйте його для тренування першої моделі, скажімо, m1. Для наступної моделі м2 перекомпонуйте навчальний набір і візьміть інший зразок з навчального набору. Ми зробимо це те ж саме для N кількості моделей. Оскільки ми перекомпонуємо навчальний набір даних і беремо з нього зразки, не видаляючи нічого з набору даних, можливо, у нас є два або більше записів даних про навчання, спільних у декількох вибірках. Ця методика перекомпонування навчального набору даних та надання зразка для моделі називається як відбір проб із заміною. Припустимо, ми тренували кожну модель і тепер ми хочемо побачити прогноз на тестових даних. Оскільки ми працюємо над двійковою класифікацією, вихід може бути 0 або 1. Тестовий набір даних передається кожній моделі, і ми отримуємо прогноз для кожної моделі. Скажімо, з N моделей більше N / 2 моделей передбачали, що це буде 1, Отже, використовуючи техніку усереднення моделі, як максимальний голос, ми можемо сказати, що прогнозований вихід для тестових даних дорівнює 1.

Підвищення

Підвищуючи, ми беремо записи з набору даних і передаємо їх базовим учням послідовно, тут базовими учнями може бути будь-яка модель. Припустимо, ми маємо кількість записів у наборі даних. Потім ми передаємо кілька записів на базу учня BL1 та навчаємо його. Після того, як BL1 проходить навчання, ми передаємо всі записи з набору даних і бачимо, як працює базовий учень. Для всіх записів, які неправильно класифікуються базовим учнем, ми лише беремо їх і передаємо іншим базовим учням, наприклад, BL2, і одночасно передаємо неправильні записи, класифіковані BL2, для навчання BL3. Це буде продовжуватися, якщо і поки ми не визначимо певну кількість базових моделей учнів, які нам потрібні. Нарешті, ми поєднуємо результат цих базових учнів та створюємо сильний учень, в результаті чого сила прогнозування моделі покращується. Добре. Тож тепер ми знаємо, як працюють Баггінг і Підвищення.

Переваги та недоліки мішка та підсилення

Нижче наведено основні переваги та недоліки.

Переваги сумки

- Найбільша перевага мішків в тому, що кілька слабких учнів можуть працювати краще, ніж один сильний учень.

- Це забезпечує стабільність і підвищує точність алгоритму машинного навчання, який використовується в статистичній класифікації та регресії.

- Це допомагає зменшити дисперсію, тобто дозволяє уникнути перенапруження.

Недоліки сумки

- Це може призвести до великої упередженості, якщо вона не моделюється належним чином, і, таким чином, може призвести до недостатністю.

- Оскільки ми мусимо використовувати декілька моделей, це стає обчислювально дорого і може не підходити в різних випадках використання.

Переваги підсилення

- Це одна з найуспішніших методик вирішення двокласних задач класифікації.

- Це добре обробляти відсутні дані.

Недоліки підсилення

- Підвищення важко здійснити в режимі реального часу через підвищену складність алгоритму.

- Висока гнучкість цих методів призводить до отримання кількох параметрів, ніж безпосередньо впливає на поведінку моделі.

Висновок

Основним результатом є те, що Bagging і Boosting - це парадигма машинного навчання, в якій ми використовуємо кілька моделей, щоб вирішити одну і ту ж проблему та отримати кращу продуктивність. І якщо ми правильно поєднаємо слабких учнів, то зможемо отримати стабільну, точну та надійну модель. У цій статті я дав основний огляд мішків та підсилення. У майбутніх статтях ви ознайомитесь з різними методами, які використовуються в обох. Наостанок я закінчу, нагадуючи, що Баггінг і Підвищення є одними з найбільш використовуваних прийомів ансамблевого навчання. Справжнє мистецтво підвищення продуктивності полягає у вашому розумінні того, коли використовувати яку модель та як налаштувати гіперпараметри.

Рекомендовані статті

Це посібник із перенесення та підсилення. Тут ми обговорюємо Вступ до переробки та підсилення, і це працює разом із перевагами та недоліками. Ви також можете ознайомитися з іншими запропонованими нами статтями, щоб дізнатися більше -

- Вступ до ансамблевих методик

- Категорії алгоритмів машинного навчання

- Алгоритм підвищення градієнта із зразком коду

- Що таке розширювальний алгоритм?

- Як створити дерево рішень?