Огляд лінійного регресійного моделювання

Коли ви починаєте вивчати алгоритми машинного навчання, ви починаєте вивчати різні способи алгоритмів ML, тобто кероване, непідконтрольне, напівконтрольне та посилене навчання. У цій статті ми будемо мати справу з контрольованим навчанням та одним із основних, але потужних алгоритмів: лінійна регресія.

Отже, контрольоване навчання - це навчання, де ми навчаємо машину розуміти взаємозв'язок між вхідними та вихідними значеннями, передбаченими набором даних навчальних даних, а потім використовувати ту саму модель для прогнозування вихідних значень для набору даних тестування. Таким чином, якщо ми вже маємо вихідні дані або маркування в нашому навчальному наборі даних, і ми впевнені, що наданий результат має сенс, що відповідає введеному, тоді ми використовуємо наглядове навчання. Керовані алгоритми навчання класифікуються на регресію та класифікацію.

Алгоритми регресії використовуються, коли ви помічаєте, що вихідний сигнал є суцільною змінною, тоді як алгоритми класифікації використовуються, коли вихід розділений на такі розділи, як Pass / Fail, Good / Average / Bad і т.д. дії з алгоритмом лінійної регресії, що є основним алгоритмом в регресії.

Підходячи до цієї регресії, перш ніж входити в алгоритм, дозвольте встановити для вас базу. У школі я сподіваюся, ви пам’ятаєте концепцію рівняння ліній. Дозвольте розповісти коротко про це. Вам дали дві точки на площині XY, тобто скажіть (x1, y1) і (x2, y2), де y1 - вихід x1, а y2 - вихід x2, тоді рівняння прямої, що проходить через точки, є (y- y1) = m (x-x1), де m - нахил прямої. Тепер, знайшовши рівняння прямої, якщо вам дано сказати точку (x3, y3), ви легко зможете передбачити, чи точка лежить на прямій чи відстань точки від прямої. Це була основна регресія, яку я зробив у школі, навіть не усвідомлюючи, що це матиме таке велике значення в машинному навчанні. Що ми зазвичай робимо в цьому, це спробувати визначити лінію рівняння або криву, яка могла б правильно відповідати входу і виходу набору даних поїзда, а потім використовувати те саме рівняння для прогнозування вихідного значення набору тестових даних. Це призведе до постійного бажаного значення.

Визначення лінійної регресії

Лінійна регресія насправді існувала дуже довго (близько 200 років). Це лінійна модель, тобто передбачає лінійну залежність між вхідними змінними (x) та однією вихідною змінною (y). Y тут обчислюється лінійною комбінацією вхідних змінних.

У нас є два типи лінійної регресії

Проста лінійна регресія

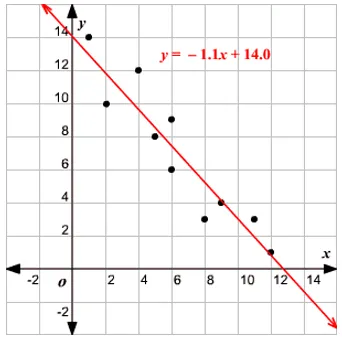

Коли є одна вхідна змінна, тобто рівняння рядка c

вважається y = mx + c, то це проста лінійна регресія.

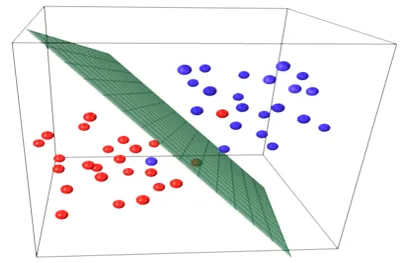

Множинна лінійна регресія

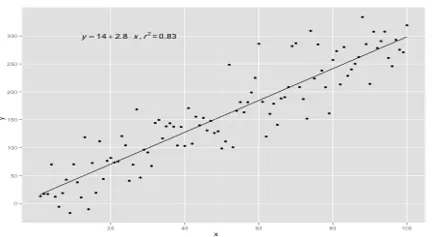

Якщо є кілька вхідних змінних, тобто рівняння лінії вважається y = ax 1 + bx 2 +… nx n, то це множинна лінійна регресія. Для підготовки або навчання рівняння регресії з даних використовуються різні методи, і найпоширеніший серед них називається звичайними найменшими квадратами. Модель, побудована за допомогою згаданого методу, називається звичайною лінійною регресією найменших квадратів або просто регресією найменших квадратів. Модель використовується, коли вхідні значення та вихідне значення, що визначаються, є числовими значеннями. Коли є лише один вхід і один вихід, то утворене рівняння є рівнянням прямої, тобто

y = B0x+B1

де коефіцієнти лінії визначаються статистичними методами.

Прості лінійні регресійні моделі дуже рідкісні для ML, оскільки, як правило, у нас будуть різні вхідні фактори для визначення результату. Коли є кілька вхідних значень і одне вихідне значення, то формується рівняння - це площина або гіперплощина.

y = ax 1 +bx 2 +…nx n

Основна ідея регресійної моделі полягає в отриманні рівняння лінії, яке найкраще відповідає даним. Найкраще підходить лінія, де сумарна похибка прогнозування для всіх точок даних вважається якомога меншою. Похибка - відстань між точкою на площині до лінії регресії.

Приклад

Почнемо з прикладу простої лінійної регресії.

Співвідношення між зростом і вагою людини прямо пропорційне. На волонтерах було проведено дослідження, щоб визначити зріст та ідеальну вагу людини та записані значення. Це буде розглядатись як наш набір даних про навчання. За допомогою даних тренувань розраховується рівняння регресійної лінії, яке дасть мінімальну помилку. Це лінійне рівняння потім використовується для прогнозування нових даних. Тобто, якщо ми даємо зріст людини, то відповідну вагу слід прогнозувати за розробленою нами моделлю з мінімальною або нульовою помилкою.

Y(pred) = b0 + b1*x

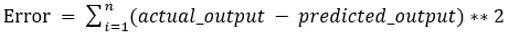

Значення b0 та b1 слід вибирати так, щоб вони мінімізували помилку. Якщо для оцінки моделі взято суму квадратичної помилки як метрику, тоді мета отримати рядок, який найкраще зменшує помилку.

Ми виводимо помилку, щоб позитивні та негативні значення не скасовували одне одного. Для моделі з одним прогноктором:

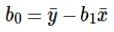

Розрахунок перехоплення (b0) у рівнянні прямої проводиться:

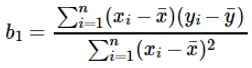

Розрахунок коефіцієнта для вхідного значення x проводиться:

Розуміння коефіцієнта b 1 :

- Якщо b 1 > 0, то x (вхід) і y (вихід) прямо пропорційні. Тобто збільшення на x збільшиться y, наприклад, зріст зростає, збільшується вага.

- Якщо b 1 <0, то x (предиктор) і y (ціль) обернено пропорційні. Тобто збільшення x зменшиться y, наприклад, швидкість збільшення транспортного засобу, час зменшується.

Розуміння коефіцієнта b 0 :

- B 0 займає залишкове значення для моделі і забезпечує, що прогноз не є упередженим. Якщо у нас немає терміна B 0, то рівняння прямої (y = B 1 x) змушене проходити через початок, тобто вхідні та вихідні значення, введені в модель, приводять до 0. Але це ніколи не буде, якщо у нас 0 у введенні, тоді B 0 буде середнім для всіх прогнозованих значень, коли x = 0. Якщо встановити всі значення прогнозованого значення 0 у випадку x = 0, це призведе до втрати даних і часто неможливо.

Окрім згаданих вище коефіцієнтів, цю модель можна також обчислити, використовуючи звичайні рівняння. Далі я обговорюватиму використання звичайних рівнянь та проектування простої / багатолінійної моделі регресії у своїй наступній статті.

Рекомендовані статті

Це посібник з лінійного регресійного моделювання. Тут ми обговорюємо визначення, типи лінійної регресії, яка включає прості та множинні лінійні регресії разом з деякими прикладами. Ви також можете переглянути наступні статті, щоб дізнатися більше -

- Лінійна регресія в R

- Лінійна регресія в Excel

- Прогностичне моделювання

- Як створити GLM в R?

- Порівняння лінійної регресії проти логістичної регресії