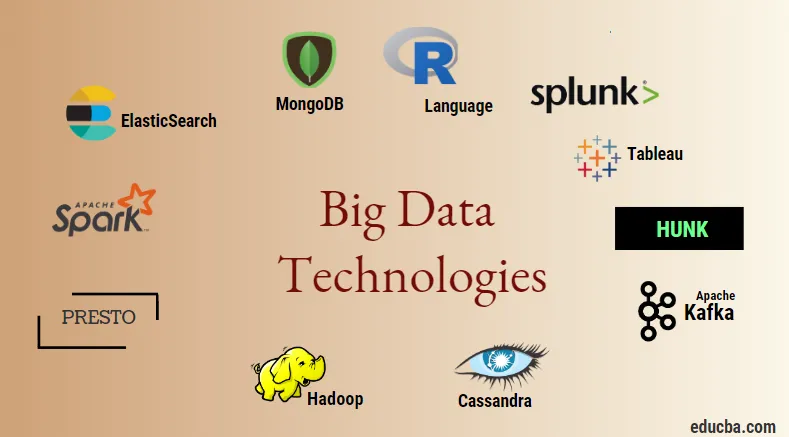

Вступ до великих технологій передачі даних

Технологія великих даних і Hadoop - це велика модна мова, як це може звучати. Оскільки у всіх галузях та домену спостерігається величезне збільшення домену даних та інформації, стає дуже важливим створити та впровадити ефективну техніку, яка б відповідала всім потребам та вимогам клієнтів та великих галузей, які відповідають за генерування даних. . Раніше дані оброблялися звичайними мовами програмування та простою структурованою мовою запитів, але зараз ці системи та інструменти, схоже, не роблять багато у випадку великих даних. Технологія великих даних визначається як технологія та програмна утиліта, яка призначена для аналізу, обробки та вилучення інформації із великого набору надзвичайно складної структури та великих наборів даних, що традиційним системам дуже важко мати справу. Технологія великих даних використовується для обробки даних у режимі реального часу та пакетних даних. Машинне навчання стало дуже важливою складовою повсякденного життя і кожної галузі, а тому управління даними за допомогою великих даних стає дуже важливим.

Типи технологій великих даних

Перш ніж почати зі списку технологій, давайте спочатку побачимо широку класифікацію всіх цих технологій. В основному їх можна класифікувати на 4 домени.

- Зберігання даних

- Аналітика

- Видобуток даних

- Візуалізація

Давайте спочатку розглянемо всі технології, які потрапляють під парасольку зберігання.

1. Hadoop : Якщо мова йде про великі дані, Hadoop - це перша технологія, яка починає грати. Це засновано на архітектурі зменшення карт і допомагає в обробці пакетних завдань та обробки пакетної інформації. Він був розроблений для зберігання та обробки даних у розподіленому середовищі обробки даних разом із товарним обладнанням та простою моделлю виконання програмування. Він може бути використаний для зберігання та аналізу даних, присутніх у різних машинах із високою швидкістю зберігання, швидкістю та низькими витратами. Це є одним з основних компонентів технології великих даних, яка була розроблена програмним фондом Apache у 2011 році та написана на Java.

1. Hadoop : Якщо мова йде про великі дані, Hadoop - це перша технологія, яка починає грати. Це засновано на архітектурі зменшення карт і допомагає в обробці пакетних завдань та обробки пакетної інформації. Він був розроблений для зберігання та обробки даних у розподіленому середовищі обробки даних разом із товарним обладнанням та простою моделлю виконання програмування. Він може бути використаний для зберігання та аналізу даних, присутніх у різних машинах із високою швидкістю зберігання, швидкістю та низькими витратами. Це є одним з основних компонентів технології великих даних, яка була розроблена програмним фондом Apache у 2011 році та написана на Java.

2. MongoDB : Ще одна дуже важлива і основна складова технології великих даних з точки зору зберігання даних - це база даних MongoDB NoSQL. Це база даних NoSQL, що означає, що реляційні властивості та інші властивості, пов'язані з RDBMS, не застосовуються до неї. Він відрізняється від традиційних баз даних RDBMS, що використовує структуровану мову запитів. Він використовує схематичні документи, і структура зберігання даних також відрізняється, тому вони корисні для зберігання великого обсягу даних. Це програма для проектування та баз даних, орієнтована на багатоплатформну програму, яка використовує документи, схожі на JSON, разом із схемою. Це стає дуже корисним випадком використання оперативних сховищ даних у більшості фінансових установ і тим самим працює над заміною традиційних мейнфреймів. MongoDB обробляє гнучкість, а також широкий спектр типів даних при великих обсягах та серед розподілених архітектур.

2. MongoDB : Ще одна дуже важлива і основна складова технології великих даних з точки зору зберігання даних - це база даних MongoDB NoSQL. Це база даних NoSQL, що означає, що реляційні властивості та інші властивості, пов'язані з RDBMS, не застосовуються до неї. Він відрізняється від традиційних баз даних RDBMS, що використовує структуровану мову запитів. Він використовує схематичні документи, і структура зберігання даних також відрізняється, тому вони корисні для зберігання великого обсягу даних. Це програма для проектування та баз даних, орієнтована на багатоплатформну програму, яка використовує документи, схожі на JSON, разом із схемою. Це стає дуже корисним випадком використання оперативних сховищ даних у більшості фінансових установ і тим самим працює над заміною традиційних мейнфреймів. MongoDB обробляє гнучкість, а також широкий спектр типів даних при великих обсягах та серед розподілених архітектур.

3. Ханк : Це корисно для доступу до даних через віддалені кластери Hadoop, використовуючи віртуальні індекси, а також використовує мову обробки пошуку Splunk, яка може бути використана для аналізу даних. Ханк може використовуватися для повідомлення та візуалізації величезної кількості даних із баз даних та джерел Hadoop та NoSQL. Він був розроблений командою Splunk в 2013 році, яка була написана на Java.

3. Ханк : Це корисно для доступу до даних через віддалені кластери Hadoop, використовуючи віртуальні індекси, а також використовує мову обробки пошуку Splunk, яка може бути використана для аналізу даних. Ханк може використовуватися для повідомлення та візуалізації величезної кількості даних із баз даних та джерел Hadoop та NoSQL. Він був розроблений командою Splunk в 2013 році, яка була написана на Java.

4. Кассандра : Кассандра формує найкращий вибір у списку популярних баз даних NoSQL, що є вільною та відкритою базою даних, яка розповсюджується та має широке стовпчасте сховище та може ефективно обробляти дані на великих товарних кластерах, тобто вона використовується для забезпечити високу доступність разом з відсутністю єдиної точки відмови. До переліку основних функцій входять такі, як розподілений характер, масштабованість, механізм стійкості до відмов, підтримка MapReduce, налаштована консистенція, властивість мови запитів, підтримується реплікація багатьох центрів обробки даних та можлива узгодженість.

4. Кассандра : Кассандра формує найкращий вибір у списку популярних баз даних NoSQL, що є вільною та відкритою базою даних, яка розповсюджується та має широке стовпчасте сховище та може ефективно обробляти дані на великих товарних кластерах, тобто вона використовується для забезпечити високу доступність разом з відсутністю єдиної точки відмови. До переліку основних функцій входять такі, як розподілений характер, масштабованість, механізм стійкості до відмов, підтримка MapReduce, налаштована консистенція, властивість мови запитів, підтримується реплікація багатьох центрів обробки даних та можлива узгодженість.

Далі ми зможемо поговорити про різні сфери технології великих даних, тобто Data Mining.

5. Presto : це популярний механізм розподіленого запиту з відкритим кодом та на основі SQL, який використовується для запуску інтерактивних запитів проти джерел даних будь-якого масштабу та розміру - від гігабайт до петабайт. З його допомогою ми можемо запитувати дані в Кассандрі, Вулику, власних сховищах даних та реляційних системах зберігання баз даних. Це механізм запитів на основі Java, який був розроблений фондом Apache у 2013 році. Кілька наборів компаній, які добре використовують інструмент Presto, це Netflix, Airbnb, Checkr, Repro та facebook.

5. Presto : це популярний механізм розподіленого запиту з відкритим кодом та на основі SQL, який використовується для запуску інтерактивних запитів проти джерел даних будь-якого масштабу та розміру - від гігабайт до петабайт. З його допомогою ми можемо запитувати дані в Кассандрі, Вулику, власних сховищах даних та реляційних системах зберігання баз даних. Це механізм запитів на основі Java, який був розроблений фондом Apache у 2013 році. Кілька наборів компаній, які добре використовують інструмент Presto, це Netflix, Airbnb, Checkr, Repro та facebook.

6. ElasticSearch : Це дуже важливий інструмент сьогодні, коли справа стосується пошуку. Це утворює важливий компонент стеку ELK, тобто еластичний пошук, Logstash та Kibana. ElasticSearch - це пошукова система, що базується на люцені, схожа на Solr і використовується для забезпечення чисто розповсюдженої, повнотекстової пошукової системи, яка може працювати з багатьма орендарями. У ньому є список документів без JSON без схем та веб-інтерфейс HTTP. Він написаний мовою JAVA та розроблений компанією Elastic в компанії 2012. Імена кількох компаній, які використовують еластичний пошук: LinkedIn, StackOverflow, Netflix, facebook, google, Accenture тощо.

6. ElasticSearch : Це дуже важливий інструмент сьогодні, коли справа стосується пошуку. Це утворює важливий компонент стеку ELK, тобто еластичний пошук, Logstash та Kibana. ElasticSearch - це пошукова система, що базується на люцені, схожа на Solr і використовується для забезпечення чисто розповсюдженої, повнотекстової пошукової системи, яка може працювати з багатьма орендарями. У ньому є список документів без JSON без схем та веб-інтерфейс HTTP. Він написаний мовою JAVA та розроблений компанією Elastic в компанії 2012. Імена кількох компаній, які використовують еластичний пошук: LinkedIn, StackOverflow, Netflix, facebook, google, Accenture тощо.

Тепер прочитаємо про всі ті технології великих даних, які є частиною аналітики даних:

7. Apache Kafka : відомий тим, що публікує-підписується або pub-sub, як це прийнято називати, - це система брокера прямого обміну повідомленнями, асинхронна система обміну повідомленнями, яка використовується для передачі даних та обробки даних на потокових даних у режимі реального часу. Він також передбачає забезпечення періоду зберігання, і дані можуть бути каналізовані за допомогою механізму виробник-споживач. Це одна з найпопулярніших платформ потокового потоку, яка дуже схожа на систему обміну повідомленнями підприємства або чергою повідомлень. На сьогоднішній день Kafka запустила багато вдосконалень, один з основних видів - це злиття Kafka, яке забезпечує додатковий рівень властивостей Kafka, таких як реєстр схем, Ktables, KSql тощо. Його було розроблено спільнотою Apache Software у 2011 році та написано на Java. Компанії, які використовують цю технологію, включають Twitter, Spotify, Netflix, Linkedin, Yahoo тощо.

7. Apache Kafka : відомий тим, що публікує-підписується або pub-sub, як це прийнято називати, - це система брокера прямого обміну повідомленнями, асинхронна система обміну повідомленнями, яка використовується для передачі даних та обробки даних на потокових даних у режимі реального часу. Він також передбачає забезпечення періоду зберігання, і дані можуть бути каналізовані за допомогою механізму виробник-споживач. Це одна з найпопулярніших платформ потокового потоку, яка дуже схожа на систему обміну повідомленнями підприємства або чергою повідомлень. На сьогоднішній день Kafka запустила багато вдосконалень, один з основних видів - це злиття Kafka, яке забезпечує додатковий рівень властивостей Kafka, таких як реєстр схем, Ktables, KSql тощо. Його було розроблено спільнотою Apache Software у 2011 році та написано на Java. Компанії, які використовують цю технологію, включають Twitter, Spotify, Netflix, Linkedin, Yahoo тощо.

8. Splunk : Splunk використовується для збору, співвіднесення та індексації потокових даних у реальному часі з репозиторію, з якого можна шукати, звідки він може генерувати звіти, графіки, інформаційні панелі, сповіщення та візуалізацію даних. Він також використовується для безпеки, відповідності та управління додатками, а також для веб-аналітики, генерування ділової інформації та бізнес-аналізу. Він був розроблений Splunk в Python, XML, Ajax.

8. Splunk : Splunk використовується для збору, співвіднесення та індексації потокових даних у реальному часі з репозиторію, з якого можна шукати, звідки він може генерувати звіти, графіки, інформаційні панелі, сповіщення та візуалізацію даних. Він також використовується для безпеки, відповідності та управління додатками, а також для веб-аналітики, генерування ділової інформації та бізнес-аналізу. Він був розроблений Splunk в Python, XML, Ajax.

9. Apache Spark : зараз з'являється найкритичніша і найбільш очікувана технологія в області технологій великих даних, тобто Apache Spark. Можливо, серед тих, хто сьогодні є найбільш затребуваним і використовує для його обробки Java, Scala або Python. Це використовується для обробки та обробки даних потокового потоку в реальному часі, використовуючи Spark Streaming, який використовує пакетні операції та операції вікна, щоб зробити це. Spark SQL використовується для створення фреймів даних, наборів даних поверх RDD, тим самим забезпечуючи гарний аромат перетворень та дій, які утворюють невід'ємну складову Apache Spark Core. Інші компоненти, такі як Spark Mllib, R і graphX, також корисні у випадку аналізу та занять машинним навчанням та наукою даних. Техніка обчислення в пам'яті - це те, що відрізняє її від інших інструментів та компонентів та підтримує широкий спектр застосувань. Він був розроблений фондом Apache Software в основному мовою Java.

9. Apache Spark : зараз з'являється найкритичніша і найбільш очікувана технологія в області технологій великих даних, тобто Apache Spark. Можливо, серед тих, хто сьогодні є найбільш затребуваним і використовує для його обробки Java, Scala або Python. Це використовується для обробки та обробки даних потокового потоку в реальному часі, використовуючи Spark Streaming, який використовує пакетні операції та операції вікна, щоб зробити це. Spark SQL використовується для створення фреймів даних, наборів даних поверх RDD, тим самим забезпечуючи гарний аромат перетворень та дій, які утворюють невід'ємну складову Apache Spark Core. Інші компоненти, такі як Spark Mllib, R і graphX, також корисні у випадку аналізу та занять машинним навчанням та наукою даних. Техніка обчислення в пам'яті - це те, що відрізняє її від інших інструментів та компонентів та підтримує широкий спектр застосувань. Він був розроблений фондом Apache Software в основному мовою Java.

10. Мова R : R - мова програмування та вільне програмне середовище, яке використовується для статистичних обчислень, а також для графіки однією з найважливіших мов у Р. Це одна з найпопулярніших мов серед науковців, шахтарів даних та фахівці з практичних даних для розробки статистичного програмного забезпечення та в основному з аналізу даних.

10. Мова R : R - мова програмування та вільне програмне середовище, яке використовується для статистичних обчислень, а також для графіки однією з найважливіших мов у Р. Це одна з найпопулярніших мов серед науковців, шахтарів даних та фахівці з практичних даних для розробки статистичного програмного забезпечення та в основному з аналізу даних.

Давайте тепер обговоримо технології, пов'язані з візуалізацією даних.

11. Tableau: це найшвидший і потужний інструмент візуалізації даних, що зростає, який використовується у сфері бізнес-аналітики. Аналіз даних - це дуже швидка машина, яка можлива за допомогою Tableau і візуалізації створюються у вигляді робочих таблиць та інформаційних панелей. Він розроблений компанією tableau в 2013 році і написаний на Python, C ++, Java та C. Компаніями, які використовують Tableau, є: QlikQ, Oracle Hyperion, Cognos тощо.

11. Tableau: це найшвидший і потужний інструмент візуалізації даних, що зростає, який використовується у сфері бізнес-аналітики. Аналіз даних - це дуже швидка машина, яка можлива за допомогою Tableau і візуалізації створюються у вигляді робочих таблиць та інформаційних панелей. Він розроблений компанією tableau в 2013 році і написаний на Python, C ++, Java та C. Компаніями, які використовують Tableau, є: QlikQ, Oracle Hyperion, Cognos тощо.

12. Діаграма : Діаграма в основному використовується для того, щоб зробити графіки та пов'язані компоненти швидшими та ефективнішими. У ньому є більш багатий набір бібліотек та API, таких як MATLAB, Python, R, Arduino, Julia та ін. Це можна використовувати інтерактивно в зошиті Юпітера та Pycharm і може використовуватися для стилізації інтерактивних графіків. Вперше він був розроблений у 2012 році та написаний на JavaScript. Кілька компаній, які використовують Plotly, - це паладіни, бітбанк тощо.

12. Діаграма : Діаграма в основному використовується для того, щоб зробити графіки та пов'язані компоненти швидшими та ефективнішими. У ньому є більш багатий набір бібліотек та API, таких як MATLAB, Python, R, Arduino, Julia та ін. Це можна використовувати інтерактивно в зошиті Юпітера та Pycharm і може використовуватися для стилізації інтерактивних графіків. Вперше він був розроблений у 2012 році та написаний на JavaScript. Кілька компаній, які використовують Plotly, - це паладіни, бітбанк тощо.

Висновок

У цій публікації ми вивчили найкращі технології великих даних, які сьогодні широко використовуються. Сподіваюся, вам сподобалось. Продовжуйте стежити за нами, щоб отримати такі повідомлення.

Рекомендовані статті

Це посібник з Big Data Technologies. Тут ми обговорили вступ та типи технологій великих даних. Ви також можете ознайомитися з іншими запропонованими нами статтями, щоб дізнатися більше -

- Що таке інструмент Splunk?

- R проти Python

- Що таке Матлаб?

- Що таке MongoDB?

- Кроки, які слід виконати у тестуванні мейнфреймів

- Типи приєднань до Spark SQL (приклади)

- Дізнайтеся про різні типи інструментів Kafka