Що таке екосистема Apache Hadoop?

Apache Hadoop Ecosystem - це рамка або платформа даних з відкритим кодом, призначена для збереження та дослідження величезних наборів даних неструктурованих. У всьому світі є багато даних, що надходять з численних цифрових платформ з провідною інноваційною технологією великих даних. Більше того, Apache Hadoop був першим, хто отримав цей потік інновацій.

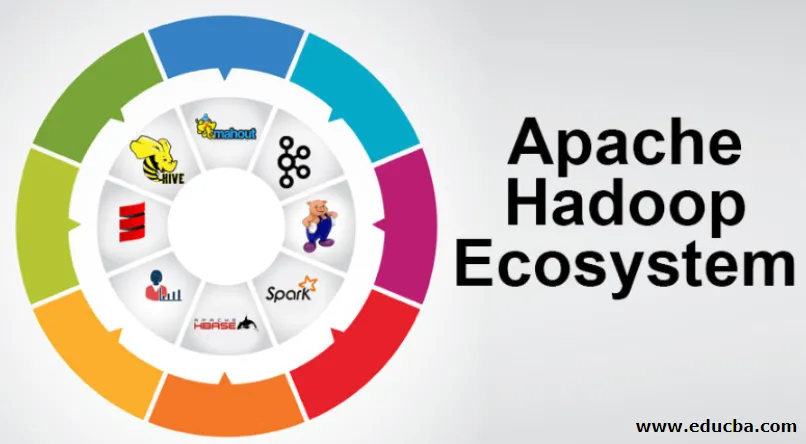

Що складається з архітектури / екосистеми Hadoop Data?

Екосистема Hadoop не є мовою програмування або послугою, це рамка або платформа, яка займається проблемами великих даних. Ви можете ідентифікувати його як набір, який охоплює різні сервіси, такі як зберігання, вживання в їжу, обслуговування та аналіз всередині нього. Тоді вивчіть та отримайте стислу думку про те, як послуги працюють виключно та у співпраці. Архітектура Apache Hadoop складається з різних інновацій та елементів Hadoop, завдяки яким навіть складні інформаційні питання можна ефективно вирішити.

Далі йде зображення кожної частини: -

1) Namenode: Він керує процесом інформації

2) Датанода: Він збирає інформацію в локальне зберігання. Для збереження всієї інформації в єдиному місці не рекомендується постійно, оскільки це може призвести до втрати інформації в разі відмови.

3) Функція відстеження завдань: Вони отримують обов'язки, призначені для підлеглого вузла

4) Карта: вона бере інформацію з потоку, і кожен рядок обробляється розділеним, щоб розділити його на різні поля

5) Зменшити: Тут поля, здобуті через "Мапу", збираються або пов'язані між собою

Екосистема Apache Hadoop - покрокова

Кожен елемент екосистеми Hadoop, як конкретні аспекти, очевидні. Комплексна перспектива структури Hadoop пропонує помітну якість для розподілених файлових систем Hadoop (HDFS), Hadoop YARN, Hadoop MapReduce та Hadoop MapReduce з екосистеми Hadoop. Hadoop навіть надає кожній бібліотеці Java, значні записи Java, відображення рівня ОС, переваги та сценарії для роботи Hadoop, Hadoop YARN - це метод для планування бізнесу та управління ресурсами. У конфігурації Hadoop HDFS забезпечує високу пропускну здатність до інформації про додатки, а Hadoop MapReduce забезпечує паралельну підготовку широкого асортименту даних на основі YARN.

Огляд екосистеми Apache Hadoop

Це важливий предмет, який потрібно зрозуміти, перш ніж розпочати роботу з екосистемою Hadoop. Нижче наведені основні компоненти:

- HDFS: Це центральна частина екосистеми Hadoop, і вона може зберегти величезну кількість неструктурованої, структурованої та напівструктурованої інформації.

- Пряжа: Це нагадує розум екосистеми Hadoop, і все обробку проводяться безпосередньо тут, що може включати розподіл активів, планування роботи та підготовку дій.

- MapReduce: Це поєднання двох процесів, описаних як Map and Reduce, і складається по суті, готуючи частини, що складають величезні інформаційні колекції, використовуючи паралельні та розпорошені алгоритми всередині екосистеми Hadoop.

- Apache Pig: це мова процедури, яка використовується для паралельних програм, що обробляють обробку величезних інформаційних колекцій у стані Hadoop, і ця мова є опцією для програмування Java.

- HBase: Це відкритий і не асоційований або NoSQL БД. Таким чином, він зміцнює всі типи інформації, таким чином, може працювати з будь-яким типом інформації в рамках Hadoop.

- Mahout, Spark MLib: Mahout використовується для машинного навчання і дає природу для створення програм машинного навчання.

- Zookeeper: Для боротьби з групами можна використовувати Zookeeper, інакше його називають лордом координації, який може дати надійні, швидкі та упорядковані оперативні адміністрації для пучків Hadoop.

- Oozie: Apache Oozie керує графіком роботи та працює як служби оповіщення та годинника всередині екосистеми Hadoop.

- Амбарі: Це завдання програмного фонду Apache, і воно може виконувати прогресивно екосистему Hadoop.

Пряжа Hadoop:

Подумайте про Пряжу як про розум вашої екосистеми Hadoop. Він відображає всю вашу обробку операцій, розподіляючи активи та плануючи обов'язки.

Він має два примітних сегменти, які є ResourceManager та NodeManager.

- ResourceManager: - Знову це основний вузол в операційному підрозділі. Він отримує запити, що готуються, після чого передає запити відповідним NodeManagers, де відбувається справжня обробка.

- NodeManagers: - Вони встановлені на кожному DataNode. Він відповідає за виконання завдання на кожній DataNode.

Як працює apache Hadoop?

- Він призначений для підйому з окремих серверів до величезної кількості машин, кожна з яких забезпечує локальні обчислення та потужність. Замість того, щоб залежати від обладнання для передачі високої доступності, сама бібліотека призначена для розрізнення та подолання розчарувань на рівні додатків, тому передає надзвичайно доступну послугу через купу комп’ютерів, кожен з яких може бути схильним до розчарувань.

- Однак дивіться далі, і в роботі значно зростає чарівність. Hadoop абсолютно модульний, що означає, що ви можете замінити практично будь-який з його сегментів на інший інструмент програмного забезпечення. Це робить архітектуру фантастично пристосованою, настільки ж потужною та ефективною.

Apache Hadoop Spark:

- Apache Spark - це система аналізу інформації в режимі реального часу в умовах розсіяних обчислень. Він реалізує обчислення в пам'яті для побудови швидкості обробки інформації.

- Він швидше обробляє велику інформацію, оскільки використовує обчислення в пам'яті та різні вдосконалення. По цих лініях вона вимагає високої сили обробки.

Як працює свиня Apache?

- Apache Pig - це вигідна система Yahoo, яка була розроблена для ефективного та плавного вивчення величезних інформаційних позицій. Це дає декілька мовних потоків інформації вищого рівня Pig Latin, яка є вдосконаленою, розширюваною та простою у використанні.

- Винятковий компонент програм «Свині», в якому їх склад доступний для суттєвої паралелізації, що полегшує догляд за значними інформаційними наборами.

Випадок використання свиней:

- Інформація про приватну охорону здоров'я особи є приватною і не повинна розкриватися іншим людям. Ці дані слід приховувати для збереження секретності, проте інформація про медичні послуги є величезною до того, що визнання та виключення індивідуальної інформації про охорону здоров'я є важливим. У таких умовах свиня Apache може використовуватися для розпізнавання даних про здоров'я.

Висновок:

- Намічено піднятися з одного сервера на величезну кількість машин, які забезпечують обчислення поблизу та потужність. Однак дивіться далі, і на роботі набагато частіше зачаровується.

- Hadoop абсолютно модульний, що означає, що ви можете торгувати практично будь-якою його частиною за альтернативним програмним інструментом. Це робить структуру фантастично пристосованою, настільки ж потужною та ефективною.

Рекомендовані статті

Це був посібник з екосистеми Apache Hadoop. Тут ми обговорили, що таке екосистема Apache Hadoop? огляд архітектури Hadoop та функціонування екосистеми Hadoop. Ви також можете ознайомитися з іншими запропонованими нами статтями, щоб дізнатися більше -

- Компоненти екосистеми Hadoop

- Як встановити Apache

- Тренування іскри Apache

- Кар'єра в Hadoop