Огляд функцій втрат у машинному навчанні

Подібно до того, як вчителі керують нами, чи ми добре чи ні в наших науковцях, функції втрати виконують ту саму роботу. Це метод оцінки того, наскільки добре наш алгоритм моделює дані. Функції втрат є основним джерелом оцінювання в сучасному машинному навчанні. Коли ви змінюєте алгоритм, щоб покращити свою модель, значення функції втрат підкаже вам, чи ви прогресуєте, чи ні. Нашою основною метою має бути зниження функціональних втрат за рахунок оптимізації. У цій статті ми поговоримо про те, як працюють функції втрат та різні типи функцій втрат.

Як працюють функції втрати?

Слово "Втрата" вказує штраф за невиконання очікуваного результату. Якщо відхилення в передбачуваному значенні, ніж очікуване значення нашої моделі, велике, то функція втрат дає більш високе число як вихід, а якщо відхилення невелике і набагато ближче до очікуваного значення, воно виводить меншу кількість.

Ось приклад, коли ми намагаємось передбачити ціну продажу будинків у містах метро.

| Прогнозували

Продажна ціна (лак) | Фактичні

Продажна ціна (лак) | Відхилення (втрата) |

| Бангалор: 45 | 0 (Усі прогнози правильні) | |

| Пуна: 35 | ||

| Ченнаї: 40 | ||

| Бангалор: 40 | Бангалор: 45 | 5 лак за Бангалор, 2 лах для Ченнаї |

| Пуна: 35 | Пуна: 35 | |

| Ченнаї: 38 | Ченнаї: 40 | |

| Бангалор: 43 | 2 лах для Бангалору, 5 лак за, Пуне2 лак за Ченнаї, | |

| Пуна: 30 | ||

| Ченнаї: 45 |

Важливо зауважити, що величина відхилення не має значення. Тут важлива річ, чи є значення, передбачене нашою моделлю, правильним чи неправильним. Функції втрати залежать від вашої постановки проблеми, до якої застосовується машинне навчання. Функція витрат - це ще один термін, який використовується взаємозамінно для функції втрат, але він має дещо інше значення. Функція втрат - це єдиний приклад навчання, тоді як функція витрат - це середня втрата за повний набір даних поїздів.

Види функцій втрат у машинному навчанні

Нижче наведено різні типи функцій втрат у машинному навчанні, які є наступними:

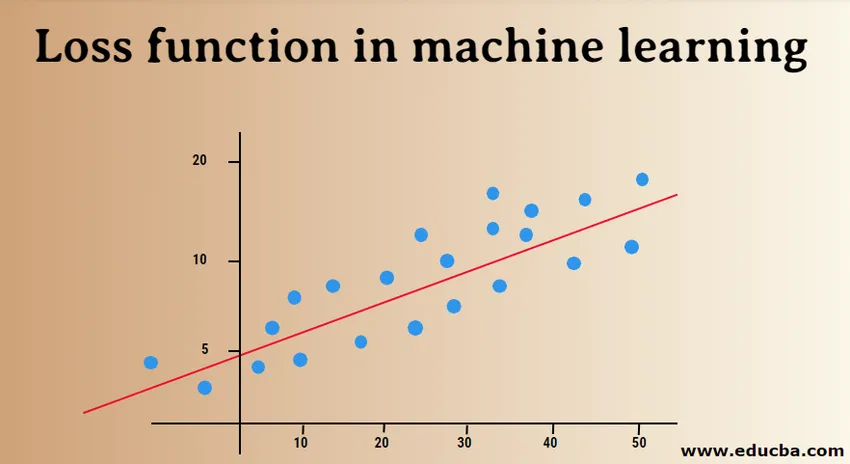

1) Регресійні втрати:

Лінійна регресія - це фундаментальна концепція цієї функції. Функції втрати регресії встановлюють лінійну залежність між залежною змінною (Y) і незалежною змінною (X), отже, ми намагаємось прилаштувати найкращу лінію в просторі на цих змінних.

Y = X0 + X1 + X2 + X3 + X4…. + Xn

X = незалежні змінні

Y = залежна змінна

- Середня втрата помилок у квадраті:

MSE (помилка L2) вимірює середню квадратичну різницю між фактичними та прогнозованими значеннями за моделлю. Вихід - це єдине число, пов'язане з набором значень. Наша мета - зменшити MSE для підвищення точності моделі.

Розглянемо лінійне рівняння, y = mx + c, ми можемо отримати MSE як:

MSE = 1 / N ∑i = 1 до n (y (i) - (mx (i) + b)) 2

Тут N - загальна кількість точок даних, 1 / N ∑i = 1 до n - середнє значення, а y (i) - фактичне значення, mx (i) + b - його передбачуване значення.

- Середня логарифмічна втрата помилок (MSLE):

MSLE вимірює співвідношення між фактичним та передбачуваним значенням. Це вводить асиметрію в кривій помилці. MSLE піклується лише про відсоткові різниці фактичних та прогнозованих значень. Це може бути хорошим вибором як функція збитків, коли ми хочемо передбачити ціни продажу будинків, ціни продажу хлібобулочних виробів і дані постійно.

Тут збитки можуть бути обчислені як середнє значення спостережуваних даних квадратних різниць між фактично перетвореними і прогнозованими значеннями, перетворені журналом, які можна навести як:

L = 1nn∑i = 1 (log (y (i) +1) −log (y (i) +1)) 2

- Середня абсолютна помилка (MAE):

МАЕ обчислює суму абсолютних різниць між фактичними та прогнозованими змінними. Це означає, що він вимірює середню величину помилок у наборі прогнозованих значень. Використовувати середню квадратичну помилку простіше вирішити, але використання абсолютної помилки є більш надійною для людей, що втратили перше місце. Отримані люди - це ті значення, які вкрай відхиляються від інших спостережуваних точок даних.

MAE може бути обчислена як:

L = 1nn∑i = 1∣∣y (i) - y (i) ∣∣

2) Функції втрати бінарної класифікації:

Ці функції втрат зроблені для вимірювання продуктивності класифікаційної моделі. У цьому точкам даних присвоюється одна з міток, тобто 0 або 1. Далі їх можна класифікувати як:

- Двійкова перехресна ентропія

Це функція втрати за замовчуванням для проблем бінарної класифікації. Перехресна ентропія втрат обчислює результативність класифікаційної моделі, яка дає вихід значення ймовірності між 0 і 1. Поперечна ентропія втрат збільшується, коли прогнозоване значення ймовірності відхиляється від фактичної мітки.

- Втрата шарніру

Втрати шарнірів можна використовувати як альтернативу перехресній ентропії, яку спочатку було розроблено для використання з алгоритмом машинного механізму підтримки вектора. Втрати шарніру найкраще справляються з проблемою класифікації, оскільки цільові значення знаходяться в наборі (-1, 1). Це дозволяє призначити більше помилок, коли є різниця в знаку між фактичними та прогнозованими значеннями. Це призводить до кращих результатів, ніж крос-ентропія.

- Втрати на шарнірі в квадраті

Розширення втрат шарніра, яке просто обчислює квадрат бала втрат шарніру. Це зменшує функцію помилок і робить її чисельно простішою. Він знаходить межу класифікації, яка визначає максимальний запас між точками даних різних класів. Втрата в шарнірній формі шарніру ідеально підходить для ТАК АБО НЕ НЕОБХІДНО з рішеннями, де відхилення ймовірності не викликає особливих проблем.

3) Функції втрати в різних класах класифікації:

Класифікація на багато класів - це прогнозні моделі, в яких точки даних віднесені до більш ніж двох класів. Кожному класу присвоюється унікальне значення від 0 до (Кількість_ов_классів - 1). Настійно рекомендується вирішити проблеми з класифікацією зображень чи тексту, де окремий папір може мати декілька тем.

- Багатокласна перехресна ентропія

У цьому випадку цільові значення знаходяться в наборі від 0 до n, тобто (0, 1, 2, 3 … n). Він обчислює бал, який приймає середню різницю між фактичними та передбачуваними значеннями ймовірності, і оцінка мінімізується для досягнення найкращої можливої точності. Багатокласова перехресна ентропія є функцією втрати за замовчуванням для проблем класифікації тексту.

- Розріджена багатокласова перехресна ентропія

Один процес гарячого кодування утруднює багатокласну перехресну ентропію в обробці великої кількості точок даних. Рідка перехресна ентропія вирішує цю проблему, виконуючи обчислення похибки без використання однокольорового кодування.

- Дивергенційна втрата Kullback Leibler

KL втрати на розбіжність обчислюють розбіжність між розподілом ймовірності та базовим розподілом та з'ясовують, скільки інформації втрачено в бітах. Вихід - це негативне значення, яке визначає, наскільки близькі два розподіли ймовірності. Для опису розбіжності KL з точки зору імовірнісного погляду використовується коефіцієнт ймовірності.

У цій статті спочатку ми зрозуміли, як функціонують функції втрат, а потім перейшли до вивчення вичерпного списку функцій втрат із використаними прикладами випадку. Однак розуміти це практично вигідніше, тому постарайтеся прочитати більше і втілити його в життя. Це ретельно прояснить ваші сумніви.

Рекомендовані статті

Це посібник з функцій втрати в машинному навчанні. Тут ми обговорюємо, як працюють функції втрат та типи функцій втрат у машинному навчанні. Ви також можете переглянути наступні статті, щоб дізнатися більше -

- Методи машинного навчання

- Вступ до машинного навчання

- Технології великих даних

- Програмне забезпечення Big Data Analytics

- Дізнайтеся про катагорії гіперпараметра

- Життєвий цикл машинного навчання | Топ 8 етапів