Введення в алгоритми науки про дані

Опис на високому рівні основних алгоритмів, що використовуються в Data Science. Як ви вже знаєте, наука даних - це поле дослідження, де рішення приймаються на основі розуміння, яке ми отримуємо з даних, а не класичних детермінованих підходів, заснованих на правилах. Зазвичай ми можемо розділити завдання машинного навчання на три частини

- Отримання даних та відображення бізнес-проблеми,

- Застосування методик машинного навчання та дотримання показників продуктивності

- Тестування та розгортання моделі

У всьому цьому життєвому циклі ми використовуємо різні алгоритми науки даних для вирішення заданої задачі. У цій статті ми поділимо найбільш часто використовувані алгоритми на основі їх типів навчання та будемо обговорювати на високому рівні.

Види алгоритмів наукових даних

На основі методологій навчання ми можемо просто розділити алгоритми машинного навчання або наукових даних на наступні типи

- Керовані алгоритми

- Непідтримувані алгоритми

1. Керовані алгоритми

Як випливає з назви, контрольовані алгоритми - це клас алгоритмів машинного навчання, де модель навчається з міченими даними. Наприклад, виходячи з історичних даних, ви хочете передбачити, чи буде клієнт заборгованість позикою чи ні. Після попередньої обробки та конструювання функцій мічених даних, контрольовані алгоритми навчаються за структурованими даними та перевіряються над новою точкою даних або в цьому випадку для прогнозування невиплати за кредитом. Давайте зануримось у найпопулярніші керовані алгоритми машинного навчання.

- До найближчих сусідів

До найближчих сусідів (KNN) - один з найпростіших, але потужних алгоритмів машинного навчання. Це контрольований алгоритм, де класифікація проводиться на основі k найближчих точок даних. Ідея, що стоїть за KNN, полягає в тому, що подібні точки кластеризуються разом, вимірюючи властивості найближчих точок даних, ми можемо класифікувати точку даних тесту. Наприклад, ми вирішуємо стандартну задачу класифікації, коли ми хочемо передбачити, що точка даних належить до класу A або до класу B.Let k = 3, тепер ми перевіримо 3 найближчих точки даних тестової точки даних, якщо дві з них належать до класу A ми будемо оголошувати точку даних тесту як клас А, інакше клас B. Правильне значення K знаходимо шляхом перехресної перевірки. Він має лінійну часову складність, тому не може бути використаний для додатків з низькою затримкою.

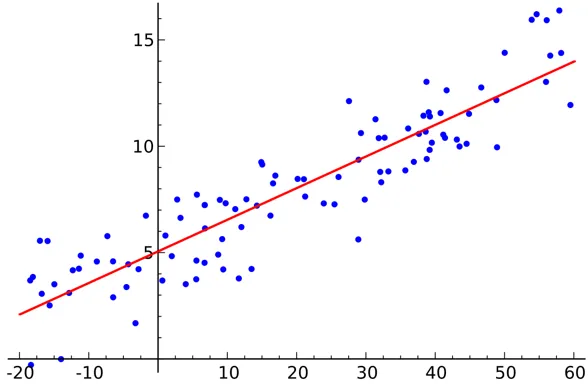

- Лінійна регресія

Лінійна регресія - це керований алгоритм науки про дані.

Вихід:

Змінна безперервна. Ідея полягає у тому, щоб знайти гіперплан, де максимальна кількість балів лежить у гіперплані. Наприклад, прогнозування кількості дощу є стандартною проблемою регресії, де можна використовувати лінійну регресію. Лінійна регресія передбачає, що зв’язок між незалежною та залежною змінними лінійний і багатоколінеарності є дуже мало або взагалі немає.

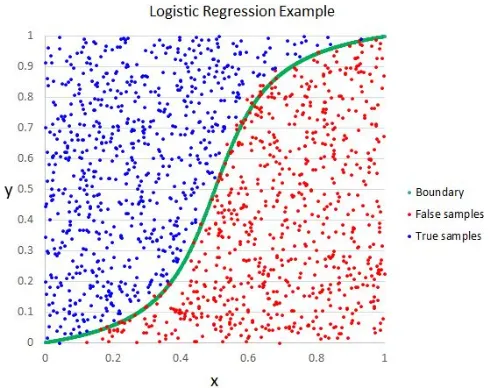

- Логістична регресія

Хоча назва говорить про регресію, логістична регресія є контрольованим алгоритмом класифікації.

Вихід:

Геометрична інтуїція полягає в тому, що ми можемо відокремлювати різні мітки класу за допомогою лінійної межі рішення. Вихідна змінна логістичної регресії є категоричною. Зверніть увагу, що ми не можемо використовувати середню квадратичну помилку як функцію витрат для логістичної регресії, оскільки вона не випукла для логістичної регресії.

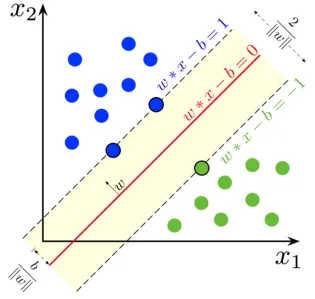

- Підтримка векторної машини

У логістичній регресії основним нашим девізом було знайти роздільну лінійну поверхню.

Вихід:

Ми можемо розглядати векторну машину підтримки як розширення цієї ідеї, де нам потрібно знайти гіперплан, який максимально збільшує запас. Але що таке маржа ?. Для вектора W (поверхні рішення, яку нам потрібно придумати) проведемо дві паралельні лінії з обох сторін. Відстань між цими двома лініями називається запасом. SVM припускає, що дані є лінійно відокремленими. Хоча ми можемо використовувати SVM для нелінійних даних, також використовуючи трюк Kernel.

- Дерево рішень

Дерево рішень - це вкладений класифікатор на основі If-Else, який використовує деревоподібну структуру графа для прийняття рішення. Дерева рішень дуже популярні і є одним з найбільш використовуваних керованих алгоритмів машинного навчання у всій області науки про дані. Він забезпечує кращу стабільність і точність у більшості випадків порівняно, ніж інші контрольовані алгоритми, і надійний для людей, що переживають люди. Вихідна змінна з дерева рішень зазвичай категорична, але вона також може бути використана для вирішення проблем регресії.

- Ансамблі

Ансамблі - популярна категорія алгоритмів наукових даних, де кілька моделей використовуються разом для досягнення кращої продуктивності. Якщо ви знайомі з Kaggle (платформою Google для тренувань та змагань із викликами щодо даних), ви знайдете, що більшість рішень-переможців використовують якісь ансамблі.

Ми можемо приблизно поділити ансамблі на наступні категорії

- Баггінг

- Підвищення

- Укладання

- Каскадні

Випадкові дерева, що сприяють ускоренню градієнтів, є прикладами деяких популярних алгоритмів ансамблю.

2. Непідтримувані алгоритми

Непідтримувані алгоритми використовуються для завдань, де дані не мають маркування. Найпопулярнішим випадком використання алгоритмів без нагляду є кластеризація. Кластеризація - це завдання згрупувати подібні точки даних без ручного втручання. Давайте обговоримо тут деякі популярні алгоритми машинного навчання без нагляду

- K Значить

K Means - рандомізований алгоритм без нагляду, який використовується для кластеризації. K Means виконує наступні кроки

1. Ініціалізуйте K пункти випадковим чином (c1, c2..ck)

2. Для кожної точки (Xi) у наборі даних

Виберіть найближчий Ci (i = 1, 2, 3..k)

Додайте Xi до Ci

3. Перерахуйте центр, використовуючи відповідні показники (тобто внутрішньокластерну відстань)

4, Повторіть крок (2) (3) до сходження

- K Значить ++

Крок ініціалізації в K означає чисто випадковий, і на основі ініціалізації кластеризація різко змінюється. K означає ++ вирішує цю проблему, ініціалізуючи k імовірнісним способом замість чистої рандомізації. K означає ++ більш стійкий, ніж класичний K.

- K Медоїди:

K медоїди - це також алгоритм кластеризації на основі засобів K. Основна відмінність між ними - центроїди K засобів, не обов'язково існують у наборі даних, що не стосується K медоїдів. K медоїди пропонують кращу інтерпретацію кластерів. K означає, що мінімізує загальну помилку квадрата, тоді як K медоїди мінімізують несхожість точок.

Висновок

У цій статті ми обговорили найпопулярніші алгоритми машинного навчання, що застосовуються в галузі науки про дані. Після всього цього вам може прийти питання про те , який алгоритм найкращий? « Очевидно, що тут немає переможця. Це залежить виключно від завдання, що стоїть під рукою, та вимог бізнесу. Як найкраща практика завжди починається з найпростішого алгоритму і збільшує складність поступово.

Рекомендовані статті

Це був посібник з алгоритмів наукових даних. Тут ми обговорили огляд алгоритмів науки про дані та два типи алгоритмів науки про дані. Ви також можете переглядати наші статті, щоб дізнатися більше -

- Платформа наукових даних

- Мови наукових даних

- Алгоритми класифікації

- Алгоритми майнінгу даних

- Найчастіше використовувані методи ансамблевого навчання

- Прості способи створення дерева рішень

- Повне керівництво життєвим циклом наукових даних