Що таке технології великих даних?

Як відомо, дані постійно розвиваються. Зростання даних викличе людські уми витягти, проаналізувати та боротися з цим. Це тому, що традиційні способи поводження з даними не підтримують цих великих даних. Великі дані описуються, як правило, трьома поняттями: об'єм, різноманітність та швидкість.

Дані тепер стали найважливішим надбанням кожної компанії. Аналіз цих великих даних допомагає компанії проаналізувати поведінку свого клієнта та передбачити відповідні речі, пов’язані з цими рішеннями, керованими даними, зробити організацію, зробити більш впевнені кроки та створити більш сильні стратегії.

Знаючи, з якою швидкістю збільшуються дані в сучасну епоху, великі дані стануть велетенським полем, в якому найближчим часом потрібно працювати. Усі студенти, освітяни, професіонали знадобляться, щоб бути в курсі нових технологій великих даних. Постійність в курсі себе принесе велику і успішну кар’єру на професійному шляху.

Технології великих даних

Тут я перелічу кілька великих технологій передачі даних з чітким поясненням, щоб зрозуміти майбутні тенденції та технології:

-

Apache Spark:

Це швидкий двигун обробки великих даних. Це створено, враховуючи обробку даних у режимі реального часу. Його багата бібліотека машинного навчання добре працювати в просторі AI та ML. Він обробляє дані паралельно та на кластерних комп’ютерах. Основний тип даних, використовуваний Spark, - це RDD (стійкий розподілений набір даних).

-

Бази даних NoSQL:

Саме нереляційні бази даних забезпечують швидке зберігання та отримання даних. Його здатність працювати з усіма видами даних, такими як структуровані, напівструктуровані, неструктуровані та поліморфні дані, є унікальною. Немає баз даних SQL таких типів:

- Бази даних документів : він зберігає дані у вигляді документів, які можуть містити безліч різних пар ключ-значення.

- Графічні сховища : він зберігає дані, які зазвичай зберігаються у формі мережі, такі як дані соціальних медіа.

- Ключові цінності : це найпростіші бази даних NoSQL. Кожен окремий елемент у базі даних зберігається як ім'я атрибута (або "ключ") разом із його значенням.

- Зберігання широких стовпців : Ця база даних зберігає дані у стовпчастому форматі, а не у форматі на основі рядків. Кассандра та HBase - хороші приклади цього.

-

Apache Kafka:

Kafka - це розподілена потокова платформа подій, яка обробляє безліч подій щодня. Оскільки це швидко і масштабується, це корисно для побудови потокових трубопроводів потокової передачі даних у реальному часі, які надійно отримують дані між системами або програмами.

-

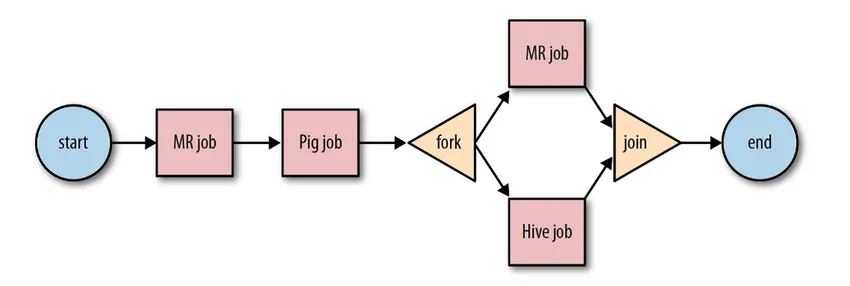

Apache Oozie:

Це система планувальників робочих процесів для управління роботами Hadoop. Ці завдання робочого процесу заплановані у формі спрямованих ациклічних графіків (DAG) для дій.

Джерело: Google

Це масштабоване та організоване рішення для діяльності з великими даними.

-

Потік повітря Apache:

Це платформа, яка планує та контролює робочий процес. Розумне планування допомагає ефективно організувати кінцеве виконання проекту. Потік повітря має можливість перезапустити екземпляр DAG, коли є екземпляр відмови. Його багатий користувальницький інтерфейс дозволяє легко візуалізувати трубопроводи, що працюють на різних етапах, наприклад, виробництво, моніторинг прогресу та усунення несправностей при потребі.

-

Промінь Apache:

Це уніфікована модель для визначення та виконання трубопроводів для обробки даних, що включають ETL та постійну потокову передачу. Рамка Apache Beam забезпечує абстрагування між логікою вашої програми та екосистемою великих даних, оскільки не існує API, який би пов'язував усі рамки, такі як Hadoop, spark тощо.

-

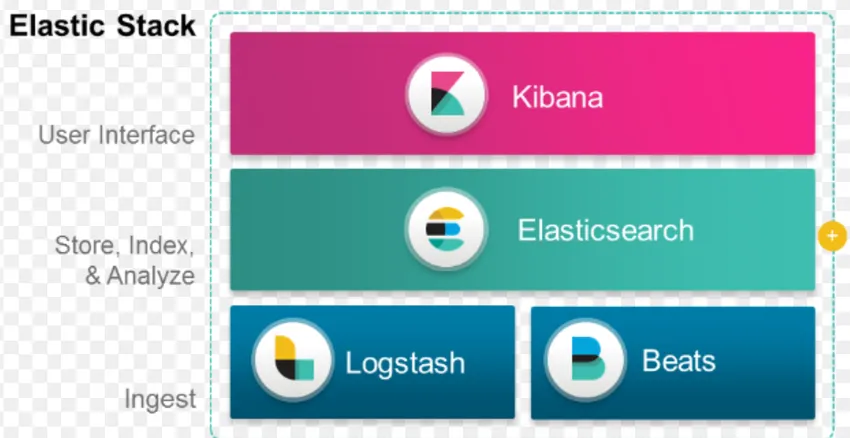

Стек ELK:

ELK відомий як Elasticsearch, Logstash та Kibana.

Elasticsearch - це база даних без схем (яка індексує кожне поле), яка має потужні можливості пошуку та легко масштабується.

Logstash - це інструмент ETL, який дозволяє нам отримувати, перетворювати та зберігати події в Elasticsearch.

Kibana - це інструмент інструментальної панелі для Elasticsearch, де ви можете проаналізувати всі збережені дані. Діяльні відомості, витягнуті з Кібани, допомагають будувати стратегії організації. Від фіксації змін до прогнозування, Кібана завжди виявлявся дуже корисним.

-

Docker & Kubernete:

Це нові технології, які допомагають програмам працювати в контейнерах Linux. Docker - це колекція інструментів з відкритим кодом, що допомагають вам "створювати, відправляти та запускати будь-яку програму в будь-якому місці".

Kubernetes також є платформою контейнерів / оркестрацій з відкритим кодом, що дозволяє великій кількості контейнерів працювати в гармонії. Це в кінцевому рахунку зменшує експлуатаційне навантаження.

-

TensorFlow:

Це бібліотека машинного навчання з відкритим кодом, яка використовується для проектування, побудови та навчання моделей глибокого навчання. Всі обчислення проводяться в TensorFlow з графіками потоку даних. Графіки містять вузли та ребра. Вузли представляють математичні операції, а ребра представляють дані.

TensorFlow корисний для досліджень та виробництва. Він був створений, маючи на увазі, що він може працювати на декількох процесорах чи графічних процесорах і навіть мобільних операційних системах. Це може бути реалізовано в Python, C ++, R та Java.

-

Presto:

Presto - SQL з відкритим кодом, розроблений Facebook, який здатний обробляти петабайти даних. На відміну від Hive, Presto не залежить від техніки MapReduce і, отже, швидше отримує дані. Його архітектура та інтерфейс досить прості для взаємодії з іншими файловими системами.

Через низьку затримку та простий інтерактивний запит на сьогоднішній день він стає дуже популярним для обробки великих даних.

-

Полібаза:

Polybase працює поверх SQL Server для доступу до даних, що зберігаються в PDW (Parallel Data Warehouse). PDW побудований для обробки будь-якого обсягу реляційних даних та забезпечує інтеграцію з Hadoop.

-

Вулик:

Hive - це платформа, яка використовується для запитів даних та аналізу даних у великих наборах даних. Він надає SQL-подібну мову запитів під назвою HiveQL, яка внутрішньо перетворюється в MapReduce і потім обробляється.

Зі швидким зростанням даних та величезним прагненням організації до аналізу великих даних Технологія принесла на ринок стільки зрілих технологій, що знання їх приносить величезну користь. На сьогоднішній день Технологія великих даних спрямована на вирішення багатьох потреб та проблем бізнесу шляхом підвищення операційної ефективності та прогнозування відповідної поведінки. Кар'єра в галузі великих даних та пов'язаних з цим технологій може відкрити багато можливостей для людини, а також для бізнесу.

Відтепер настав час для впровадження технологій великих даних.

Рекомендовані статті

Це було керівництвом щодо Що таке великі технології передачі даних. Тут ми обговорили кілька великих технологій передачі даних, як Hive, Apache Kafka, Apache Beam, ELK Stack тощо. Ви також можете переглянути наступну статтю, щоб дізнатися більше -

- Що таке глибоке навчання?

- Путівник по Minitab?

- Що таке технологія Salesforce?

- Що таке аналітика великих даних?